1. Steps of PCA

1) subtract the mean from the data and send it at zero to avoid numerical problems

2) divide by the standard deviation to make the data unit-free

3) compute the eigenvalues and eigen vectors of the data covariance matrix

4) can project any data point onto the principal subspace

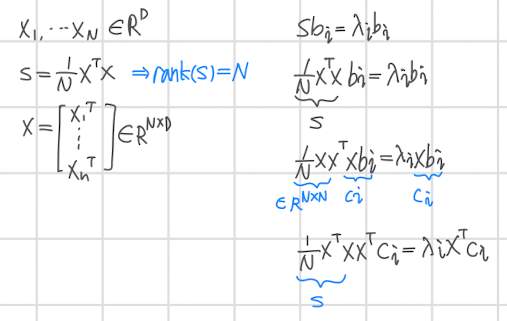

2. PCA in high dimensions

3. Steps of PCA

- 대충 pass 하려고 했는데 결국 거의 다 풀어낸..퀴즈였다..ㅜㅜ

- PCA는 결국 고차원의 데이터를 낮은 차원으로 최대한 정보의 손실없이 보내는 과정이다.

이를 위해서 손실을 최소화하는 지점을 찾아야하고 그 방법으로 고유벡터 등 다양한 개념이 사용된다. - 여러 변수들의 상관관계를 나타내는 Covariance matrix,

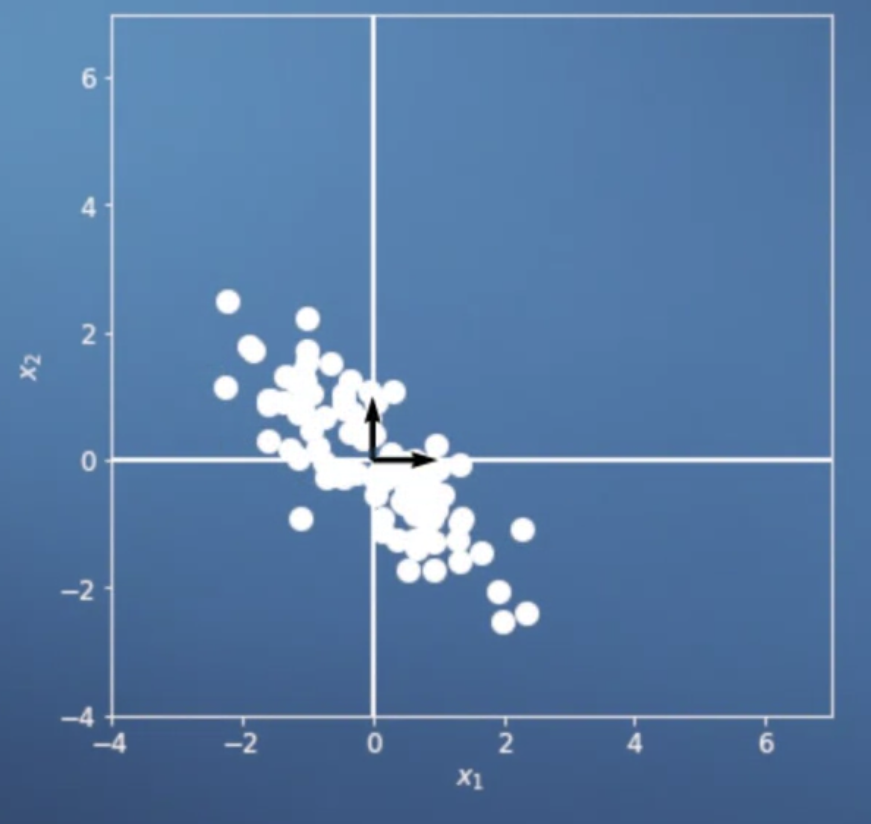

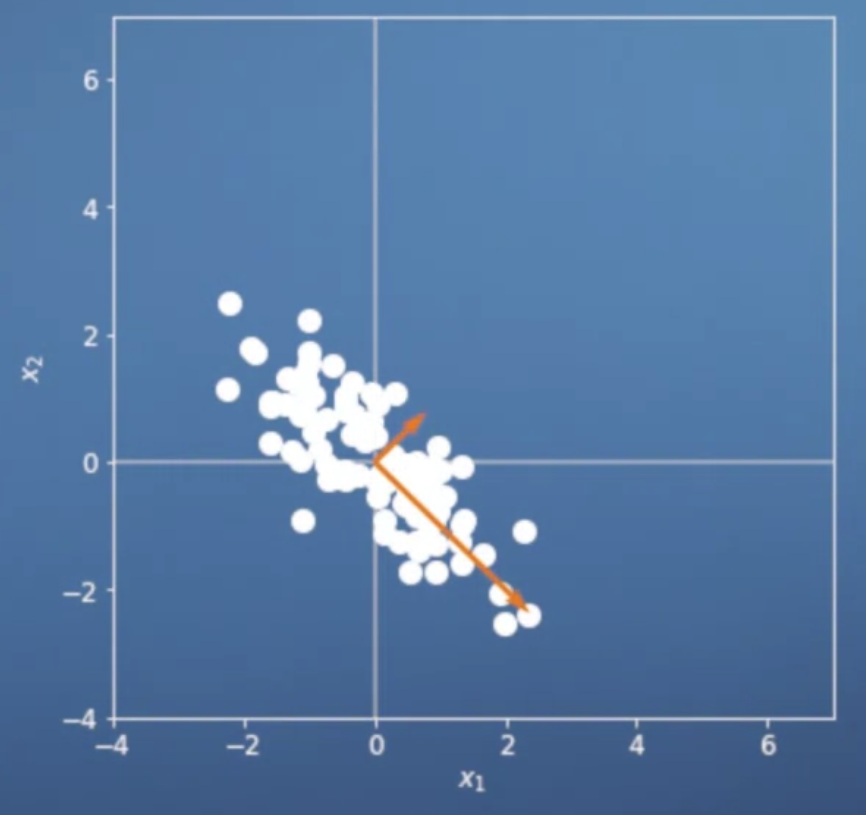

데이터가 펼쳐진 방향을 나타내는 Eigenvectors,

데이터가 펼쳐진 정도를 나타내는 Eigenvalues의 개념 또한 사용된다. - 기본적으로 PCA를 위해서는 데이터의 평균(mean)을 빼고 표준편차(std)로 나눠주어야 한다.

여기에서는 빼는 과정만 필요하므로 np.mean 함수를 axis = 0 을 기준으로 구하자. - 2차원 데이터들의 군집 상태를 보고 covariance matrix를 대략적으로 구할 수 있다.

- convariance matrix를 정확하게 구하는 task가 있는데 왜 틀렸는지 도무지 알 수가 없었다.

- 기존 데이터로부터 평균을 빼서 정규화시킨 데이터의 고유벡터는 우상향을 가리킬 것이다.

- PCA는...

1) 이미지 압축 및 얼굴 인식에 사용될 수 있다.

2) 데이터의 패턴과 경향을 파악하는데 도움이 된다.

3) 저장에 필요한 데이터의 양을 줄일 수 있다.

4. Principal Components Analysis

- 주피터 노트북 환경에서 수행하는 프로그래밍 과제

- 난이도가 매우 높고 이해하지 못한 채로 지나간 것들이 많으므로 반드시 반드시 복습해야 한다.

지금까지 배운 PCA 내용들이 집약되어 있다. - + optional 강의로 Other interpretations of PCA 는 흘려들었다.

지금은 이전 내용들 기억하기도 벅차다.

출처: Coursera, Mathematics for Machine Learning: PCA, Imperial College London.

'PCA > 4주차' 카테고리의 다른 글

| PCA derivation(2) - 복습必 (0) | 2022.10.14 |

|---|---|

| PCA derivation(1) - 복습必 (0) | 2022.10.13 |