![]()

NLP 분야의 (지금은 분야를 막론하고 그렇지만) 전설적인 논문인 Attention Is All You Need를 읽고 간단히 정리해보았습니다. 100% 이해하는 것이 쉽지 않기도 하고.. 자세히 정리하다가는 하루가 꼬박 날아갈 가능성이 있어 핵심적인 개념들 위주로 정리하며 복습해볼 생각입니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success [Google Brain, Google Research, University of Toronto] - 오직 attention mechanism만으로 구성된 simple network architecture, Transformer를 제안 - 영어를 다른 언어로 번역하는 태스크에서 뛰어난 일반화 성능을 보임 1..

![]()

관심있는 NLP 논문을 읽어보고 ChatGPT를 이용해 정리했습니다. (요약을 제외한 모든 내용은 ChatGPT가 요약한 내용입니다 😁) 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success [Carnegie Mellon University, Princeton University] - selective SSMs을 simplified end-to-end neural network architecture로 통합함 - attention 또는 심지어 MLP block을 포함하지 않음 1. Introduction 기초 모델(FMs)의 개요 FMs는 대규모 데이터로 사전 학습된 후 하위 작업에 적용되는 대형 모델로, 현대 머신러닝에서 효과적인 패러다임으로 부상...

![]()

예전(2020.10)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success [Google Reserach, Brain Team] image patch의 sequence에 pure transformer를 적용하여 image classification을 수행. 타 모델 대비 적은 computational resource를 요하면서도 우월한 성능을 보임. 배경 transformer가 등장하며 NLP를 집어 삼키게 된 이후로, 이 아키텍쳐를 이미지 분야에 적용하고자 하는 여러 시도들이 있었습니다. 각 픽셀을 대상으로 self-attention을 적용하거나 지엽적으로 self-attention을 적용하는 등의 접근이..

![]()

최근(2023.07)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success 전통적인 somftmax 기반의 attention 모델이 아닌 Linear Attention 기반의 LLM, TransNormerLLM. positional embedding, linear attention acceleration, gating mechanism, tensor normalization, inference acceleration 등의 방식을 적용. linear attention을 가속화하는 Lightning Attention을 제시. 배경 대부분의 인공지능 모델들은 Transformer의 아키텍쳐를 기반으로 삼고 엄청난..

![]()

최근(2023.07)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success LLM의 기반이 되는 Retentive Network (RETNET)을 제안. scaling results, parallel training, low-cost deployment, efficient inference를 달성했다고 주장. 배경 트랜스포머 기반의 모델들은 그 뛰어난 성능 덕분에 많은 분야를 집어 삼키고 있지만, 지나치게 많이 요구되는 메모리 사용량과 연산량으로 인해 사용에 제약이 많습니다. 따라서 빠른 속도로 연산이 가능하면서도 준수한 성능을 낼 수 있는 모델에 대한 연구는 다방면으로 이뤄지고 있습니다. 모델의 성능과 관..

![]()

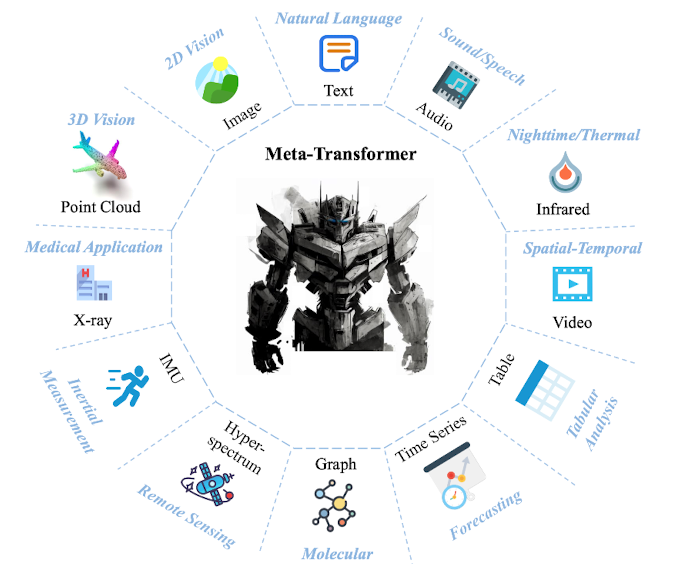

최근(2023.07)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success multimodal 전용의 pair data 없이 frozen encoder로 feature를 추출하여, 12개의 modality에 대해 동시에 이해할 수 있는 transformer 기반 모델, Meta-Transformer 배경 마치 인간의 뇌처럼, 인공지능 모델도 한 modality에서 얻은 지식을 다른 곳으로 전이할 수 있도록 하는 연구가 이어지고 있습니다. 하지만 근본적으로 다른 modality 데이터는 그 특징과 성질이 너무 다르기 때문에 쉽지 않은 문제죠. 그래서 지금까지는 대부분 image - text 수준을 벗어나는 연..