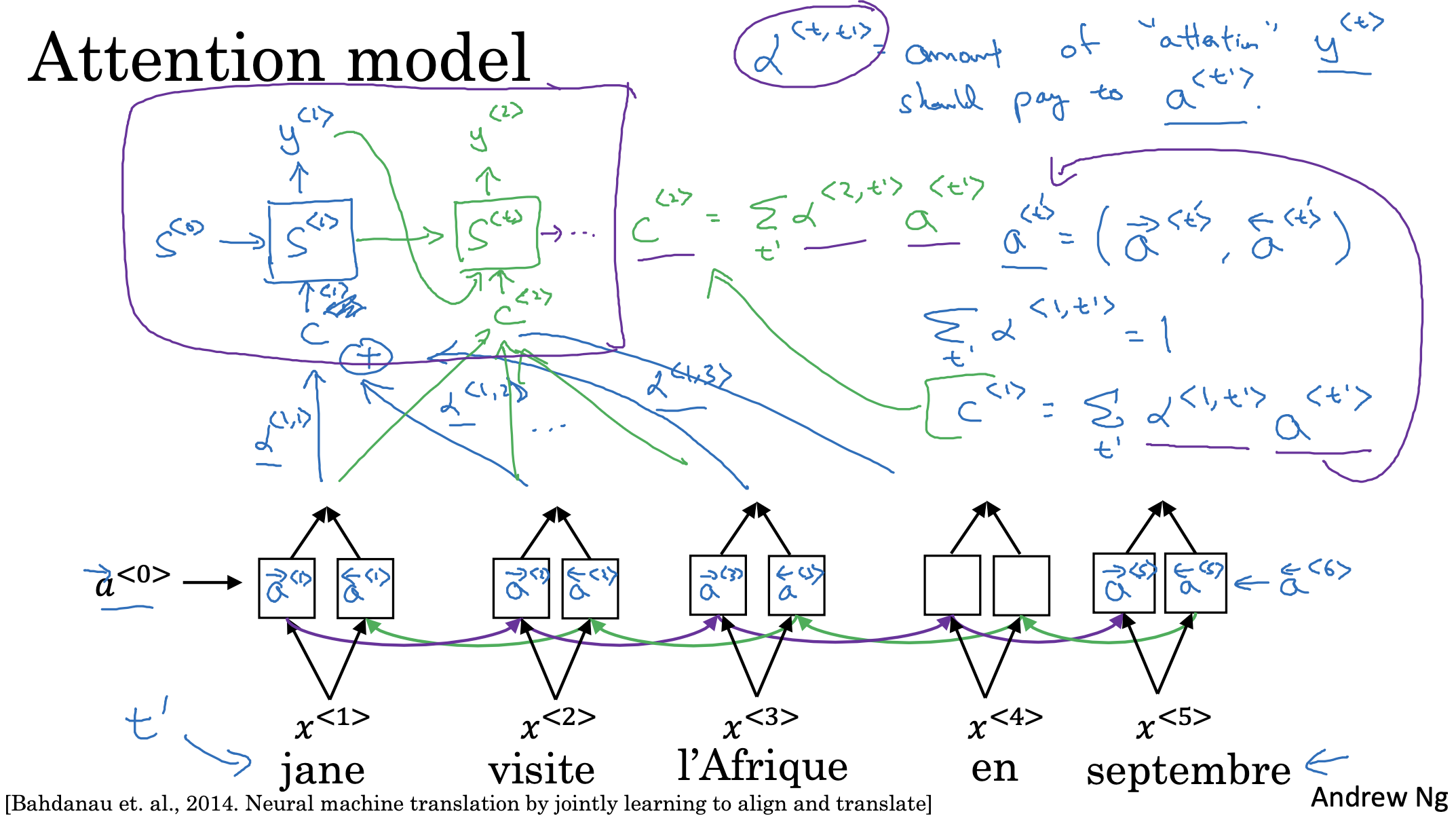

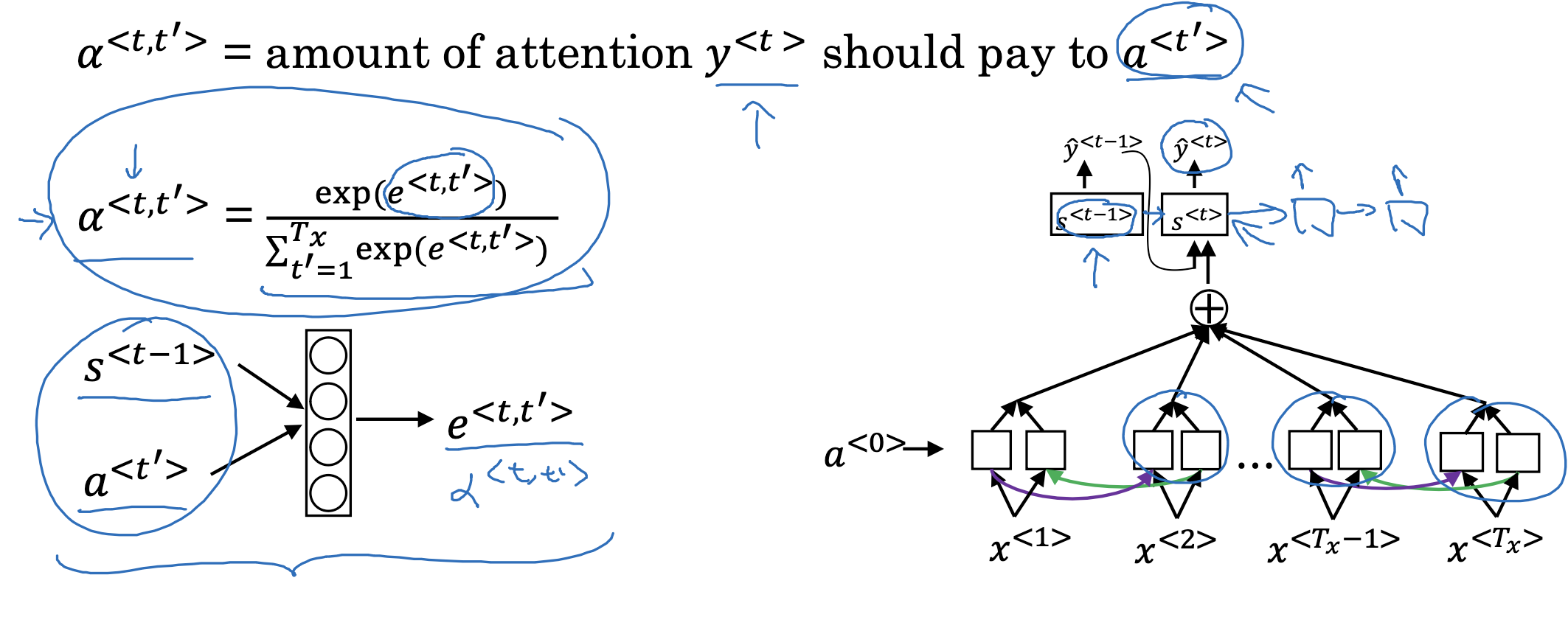

Attention model

기존과 크게 다른 것은 없고 attention model에 필요한 context를 어떻게 계산하는지 식으로 설명하고 있습니다.

attention은 말 그대로 집중이며, 전체 문장을 구성하는 요소에 따라 다른 비중을 두는 방식이라고 이해할 수 있습니다.

따라서 attention 가중치를 나타내는 alpha의 총합은 1로 고정됩니다.

그리고 이 가중치와 실제 값을 곱한 것들의 누적합이 각 스텝의 context가 됩니다.

이를 지금까지의 state와 함께 입력으로 삼아 새로운 y hat을 만든다고 볼 수 있습니다.

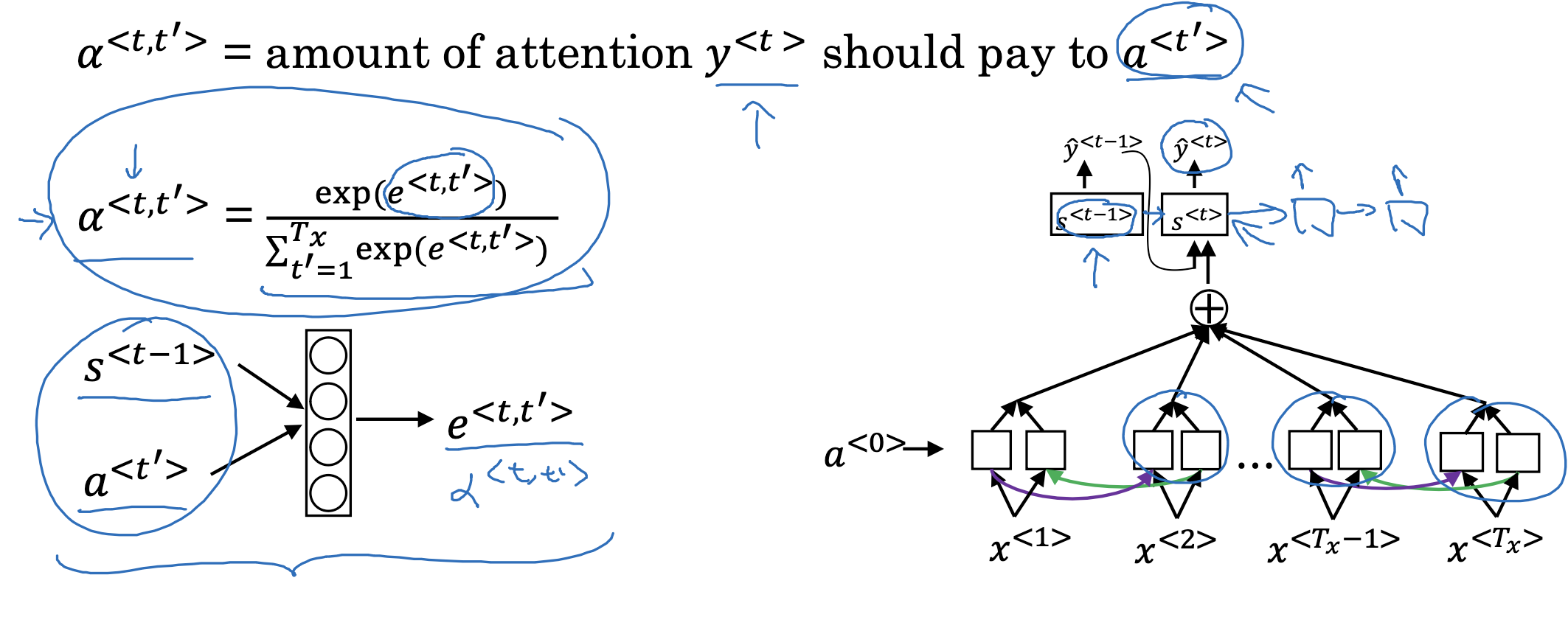

Computing attention a<t, t'>

attention 가중치를 나타내는 alpha는 softmax 함수로 구합니다.

(그렇기 때문에 총합이 1이라는 것을 자연스럽게 알 수 있죠)

이를 이전 step(t)의 state(s)와 결합하여 현재 시점의 e를 구하는 것을 알 수 있습니다.

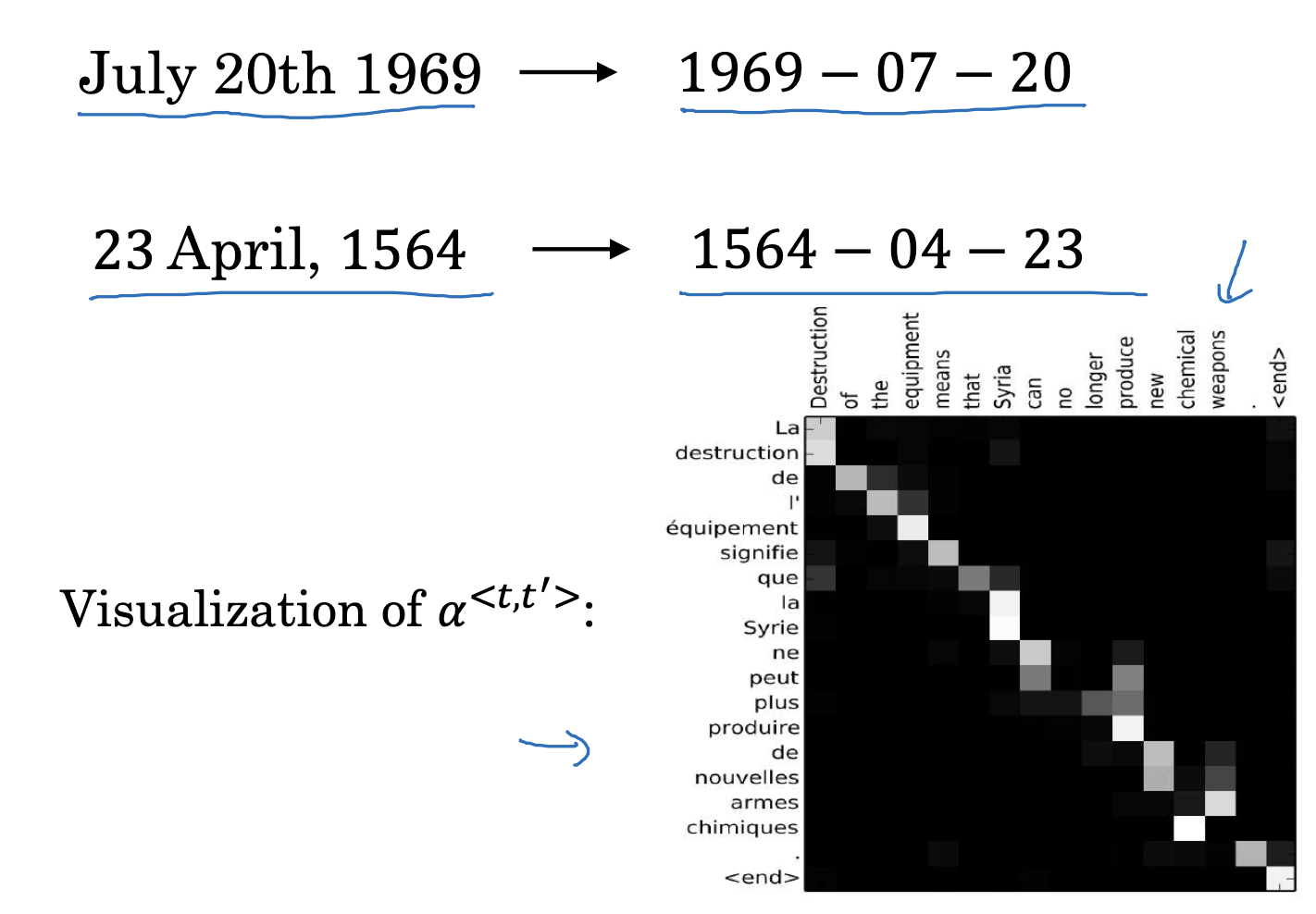

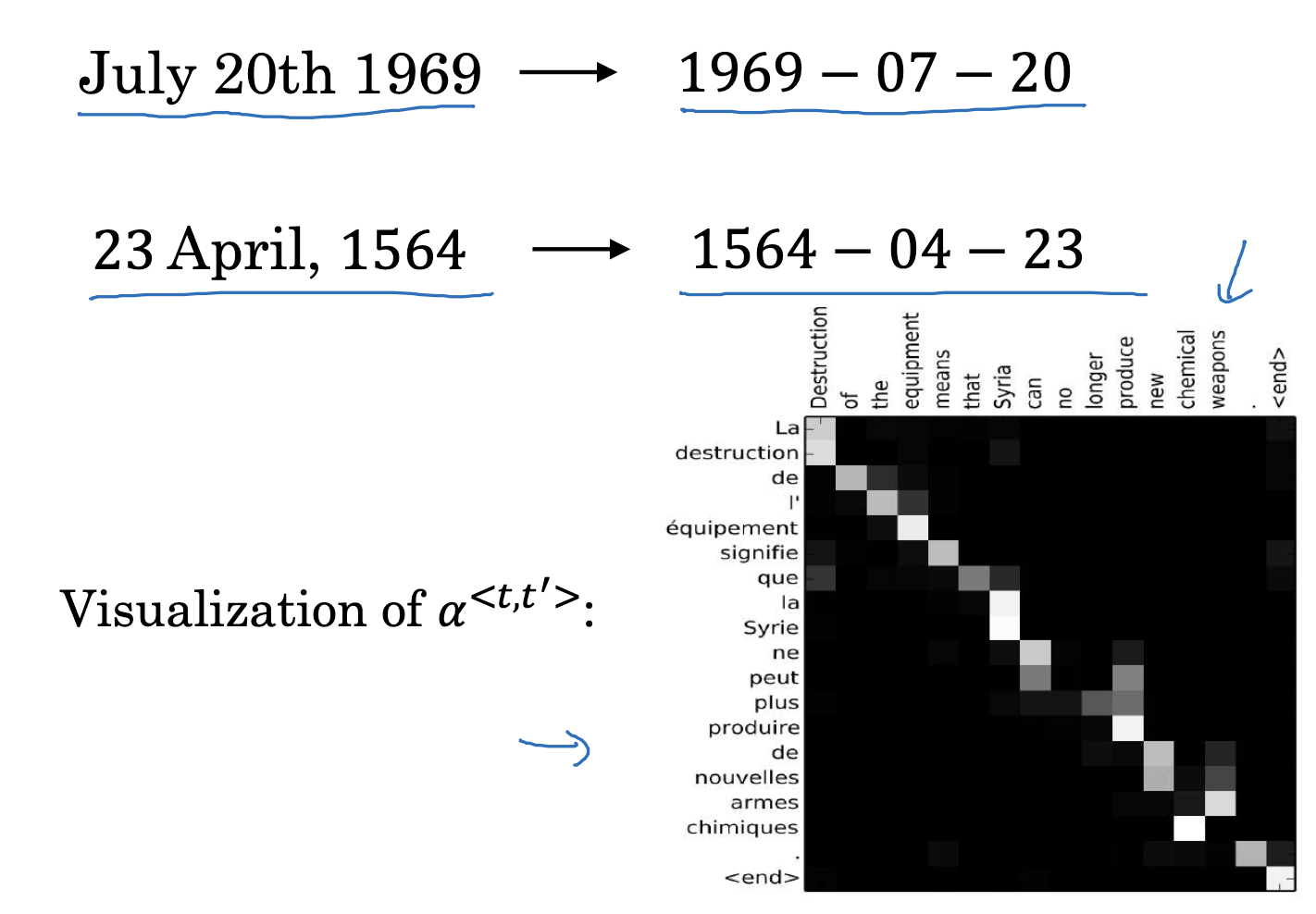

Attention examples

attention 모델을 사용하면 위처럼 어떤 형태로 날짜를 입력하더라도 원하는 형태로 출력하게 만들 수도 있습니다.

또한 attention, 즉 서로 얼마만큼의 영향을 주고 받아야 하는지를 시각화한 것이 우측 아래의 사각형과 같습니다.

서로 다른 두 언어에서 관계가 높은 단어쌍이 무엇인지를 시각적으로 확인할 수 있습니다.

출처: Coursera, Sequence Models, DeepLearning.AI

'Sequence Models > 3주차' 카테고리의 다른 글

| Speech Recognition(2) : Trigger Word Detection (2) | 2023.04.28 |

|---|---|

| Speech Recognition(1) : Speech Recognition (0) | 2023.04.28 |

| Various Sequence To Sequence Architectures(7) : Attention Model Intuition (0) | 2023.04.28 |

| Various Sequence To Sequence Architectures(6) : Blue Score (Optional) (0) | 2023.04.28 |

| Various Sequence To Sequence Architectures(5) : Error Analysis in Beam Search (0) | 2023.04.28 |

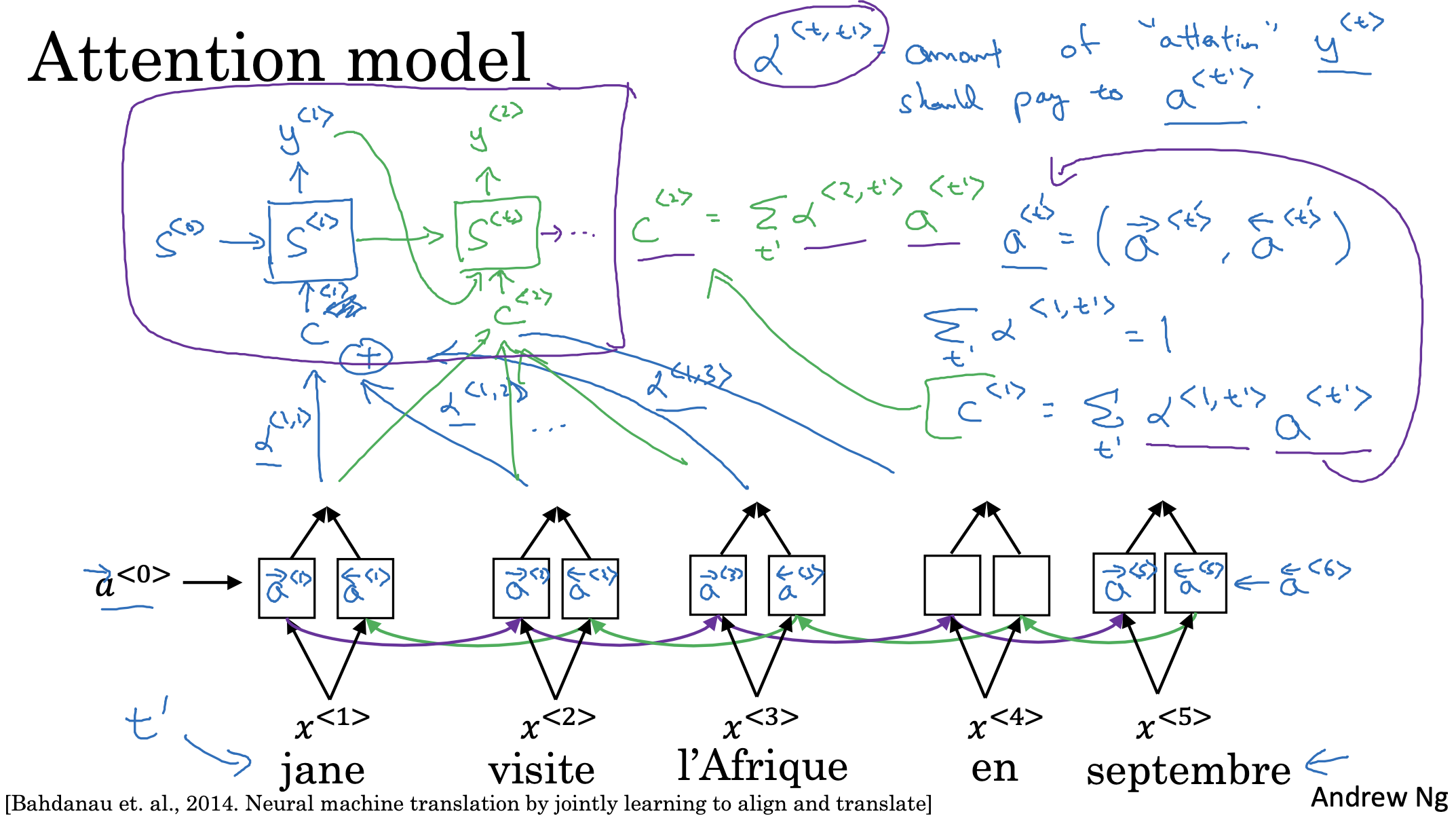

Attention model

기존과 크게 다른 것은 없고 attention model에 필요한 context를 어떻게 계산하는지 식으로 설명하고 있습니다.

attention은 말 그대로 집중이며, 전체 문장을 구성하는 요소에 따라 다른 비중을 두는 방식이라고 이해할 수 있습니다.

따라서 attention 가중치를 나타내는 alpha의 총합은 1로 고정됩니다.

그리고 이 가중치와 실제 값을 곱한 것들의 누적합이 각 스텝의 context가 됩니다.

이를 지금까지의 state와 함께 입력으로 삼아 새로운 y hat을 만든다고 볼 수 있습니다.

Computing attention a<t, t'>

attention 가중치를 나타내는 alpha는 softmax 함수로 구합니다.

(그렇기 때문에 총합이 1이라는 것을 자연스럽게 알 수 있죠)

이를 이전 step(t)의 state(s)와 결합하여 현재 시점의 e를 구하는 것을 알 수 있습니다.

Attention examples

attention 모델을 사용하면 위처럼 어떤 형태로 날짜를 입력하더라도 원하는 형태로 출력하게 만들 수도 있습니다.

또한 attention, 즉 서로 얼마만큼의 영향을 주고 받아야 하는지를 시각화한 것이 우측 아래의 사각형과 같습니다.

서로 다른 두 언어에서 관계가 높은 단어쌍이 무엇인지를 시각적으로 확인할 수 있습니다.

출처: Coursera, Sequence Models, DeepLearning.AI

'Sequence Models > 3주차' 카테고리의 다른 글

| Speech Recognition(2) : Trigger Word Detection (2) | 2023.04.28 |

|---|---|

| Speech Recognition(1) : Speech Recognition (0) | 2023.04.28 |

| Various Sequence To Sequence Architectures(7) : Attention Model Intuition (0) | 2023.04.28 |

| Various Sequence To Sequence Architectures(6) : Blue Score (Optional) (0) | 2023.04.28 |

| Various Sequence To Sequence Architectures(5) : Error Analysis in Beam Search (0) | 2023.04.28 |