(1) Why Sequence Models?

Examples of sequence data

- Sequence data 역시 입력 x, 출력 y의 구조는 동일합니다.

- 이때 x는 반드시 sequence일 필요는 없습니다. nothing, 아무것도 아닐 수 있고 때로는 integer(정수)일수도 있습니다.

(2) Notation

Motivating example

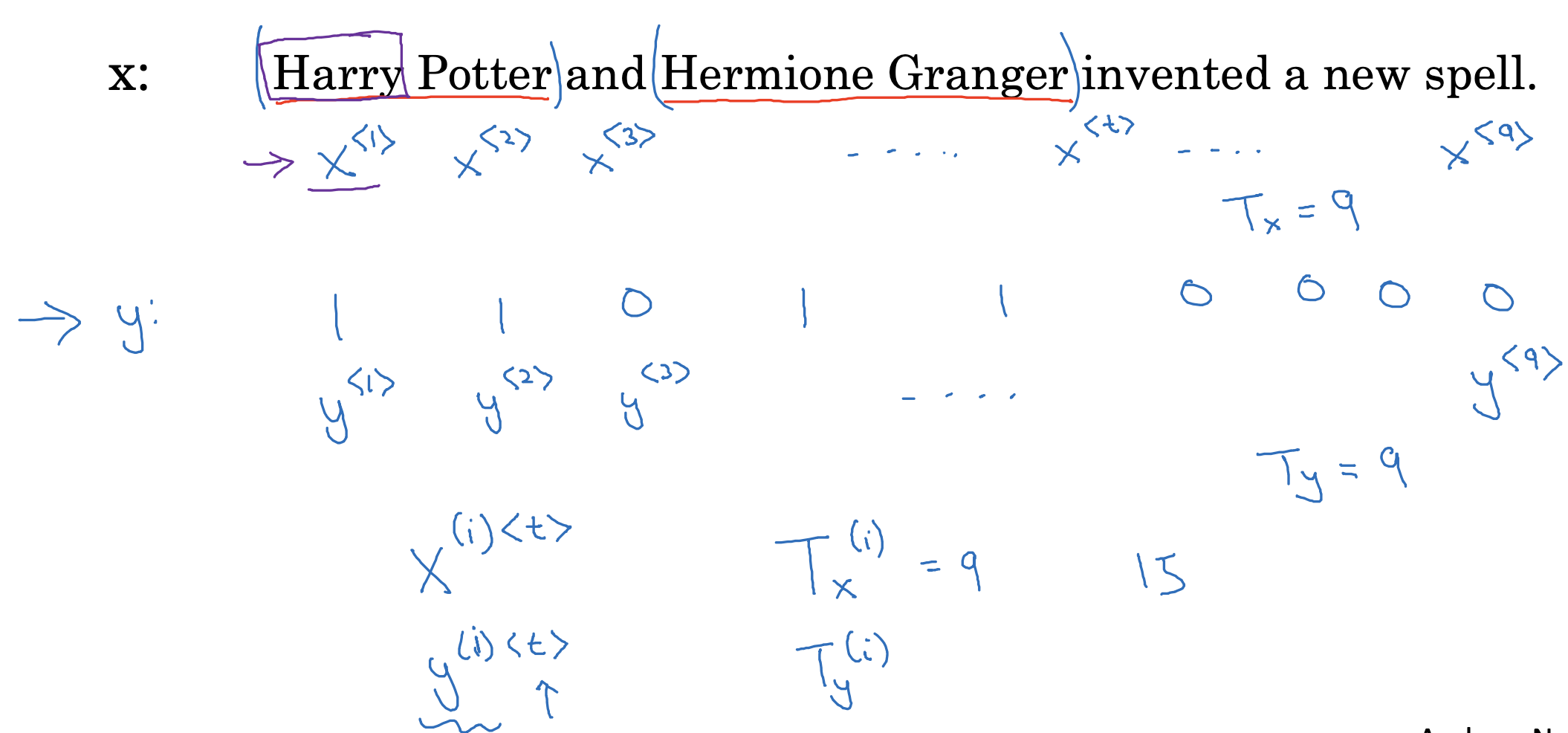

- 위와 같은 문장이 입력으로 주어졌을 때 각 단어로 쪼개어서 구분합니다.

- 한 입력 내에서 몇 번 째의 위치인지 구분하는 것은 < > 기호를 사용하고, 전체 예시 중에서 몇 번째에 해당하는지는 ( ) 기호를 사용합니다.

- 위 문장에서 이름을 나타내는 단어에 해당하면 1, 그렇지 않으면 0을 정답(label, y)으로 부여합니다.

Representing words

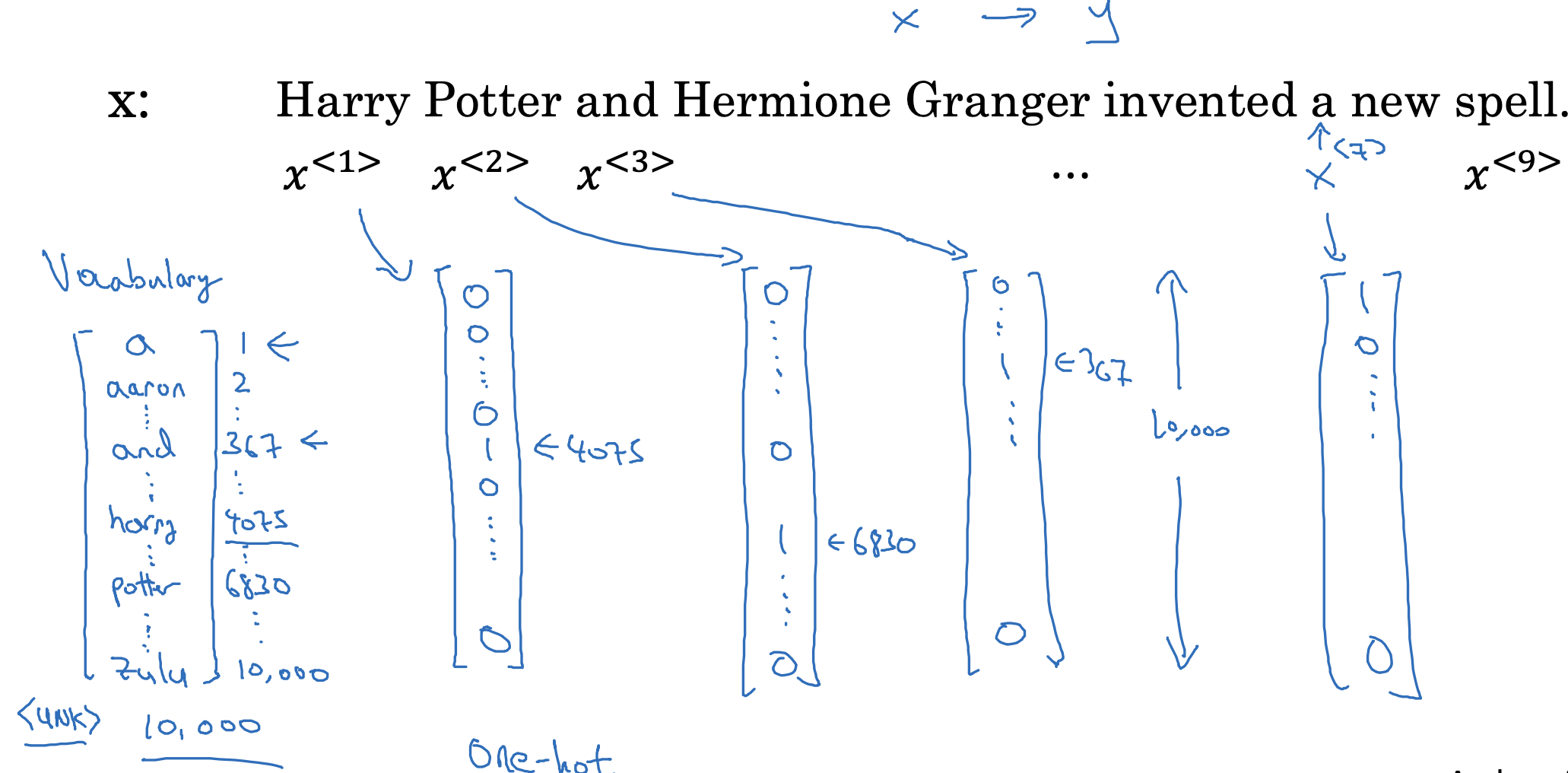

- 단어를 인공지능 모델이 이해할 수 있는 숫자 형태로 represent 할 필요가 있습니다.

- 이를 위해 생성한 일종의 단어 사전을 Vocabulary(줄여서 Vocab)이라고 부릅니다.

여기에는 우리가 단어라고 인식할 수 있는 것들을 쭉 나열해서 인덱스로 숫자와 매칭합니다. - 예를 들어 a는 1번, 마지막 zulu는 10,000번으로 구성된 10,000개 짜리 vocab인 것입니다.

- 이를 위해 생성한 일종의 단어 사전을 Vocabulary(줄여서 Vocab)이라고 부릅니다.

- 이를 문장 내 각 단어와 매칭하여 one-hot vector로 표현합니다.

- 예를 들어 a라는 단어는 x<7> = [1, 0, ... , 0 ] 이 되고, 나머지는 각 인덱스에 맞게끔 1을 취하고 나머지는 0인 one-hot vector가 됩니다.

- 만약 vocab에 들어있지 않는 단어라면 <UNK> 토큰(unknown의 약자)으로 변경 됩니다.(이후 강의에서 다룬다고 합니다)

출처: Coursera, Sequence Models, DeepLearning.AI

'Sequence Models > 1주차' 카테고리의 다른 글

| Recurrent Neural Networks(7) : Sampling Novel Sequences (0) | 2023.04.14 |

|---|---|

| Recurrent Neural Networks(6) : Language Model and Sequence Generation (0) | 2023.04.14 |

| Recurrent Neural Networks(5) : Different Types of RNNs (0) | 2023.04.14 |

| Recurrent Neural Networks(4) : Backpropagation Through Time (0) | 2023.04.13 |

| Recurrent Neural Networks(3) : Recurrent Neural Network Model (0) | 2023.04.13 |