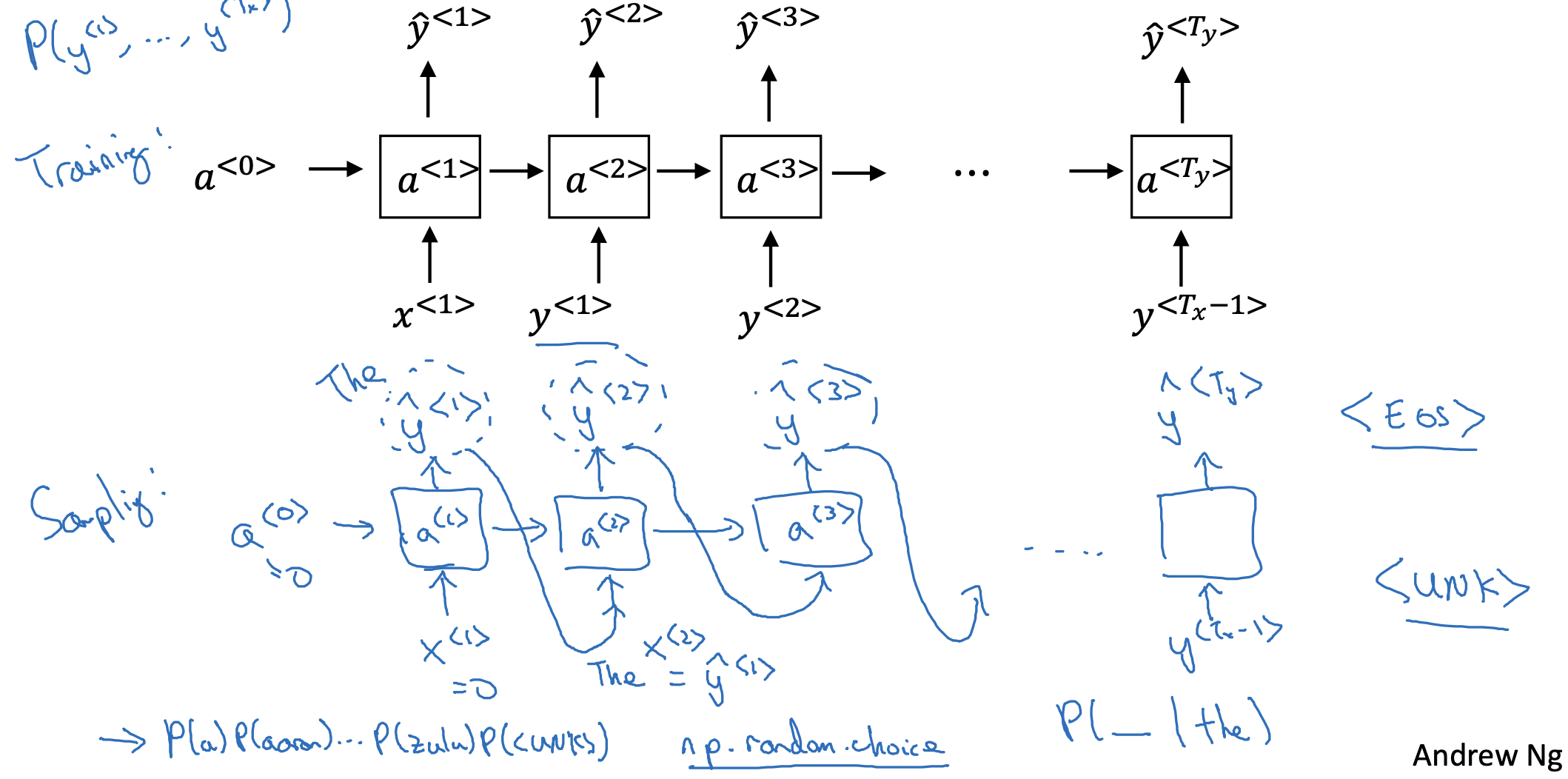

Sampling a sequence from a trained RNN

- 이전 강의에서 배운 것처럼 RNN 모델이 학습을 마치고 나면 sampling을 해봅니다.

- a<0>는 0으로 초기화된 상태에서 시작하면, 각 토큰들을 기준으로 다음에 등장할 확률이 가장 높은 토큰 하나를 예측하게 됩니다.

- 이때 <UNK> 토큰이 등장하지 않게 하려면 resampling 하게 하는 등의 조치를 취할 수 있습니다.

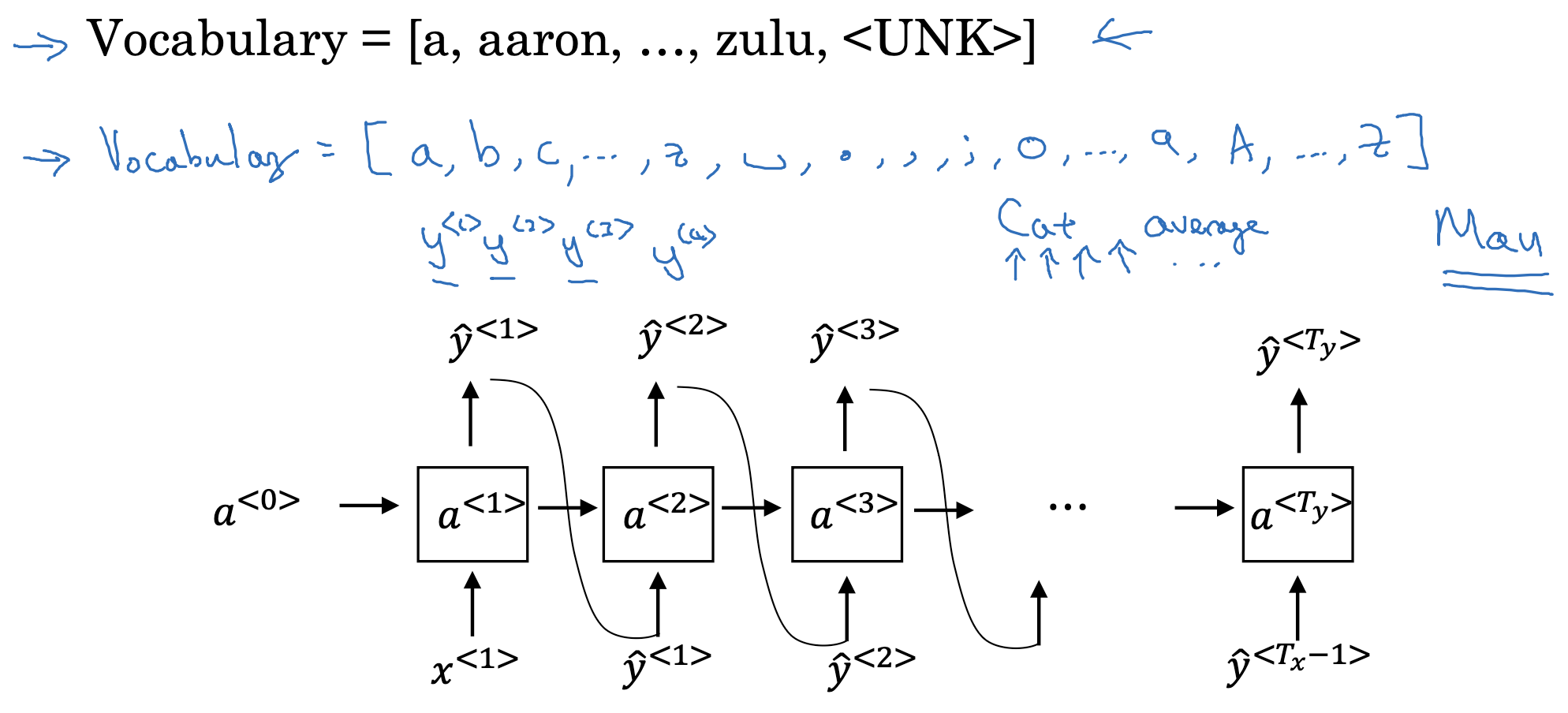

Character-level language model

- 지금까지 살펴본 것은 단어 단위의 RNN이었지만, 이 토큰을 글자 단위로 만들 수도 있습니다.

- 이때는 소문자, 대문자, 공백, 특수 기호 등등 다양한 문자가 vocab에 포함될 수 있겠죠.

- 하지만 모든 글자 단위로 연산을 하게 되면 비용이 비싸다는 단점이 있습니다.

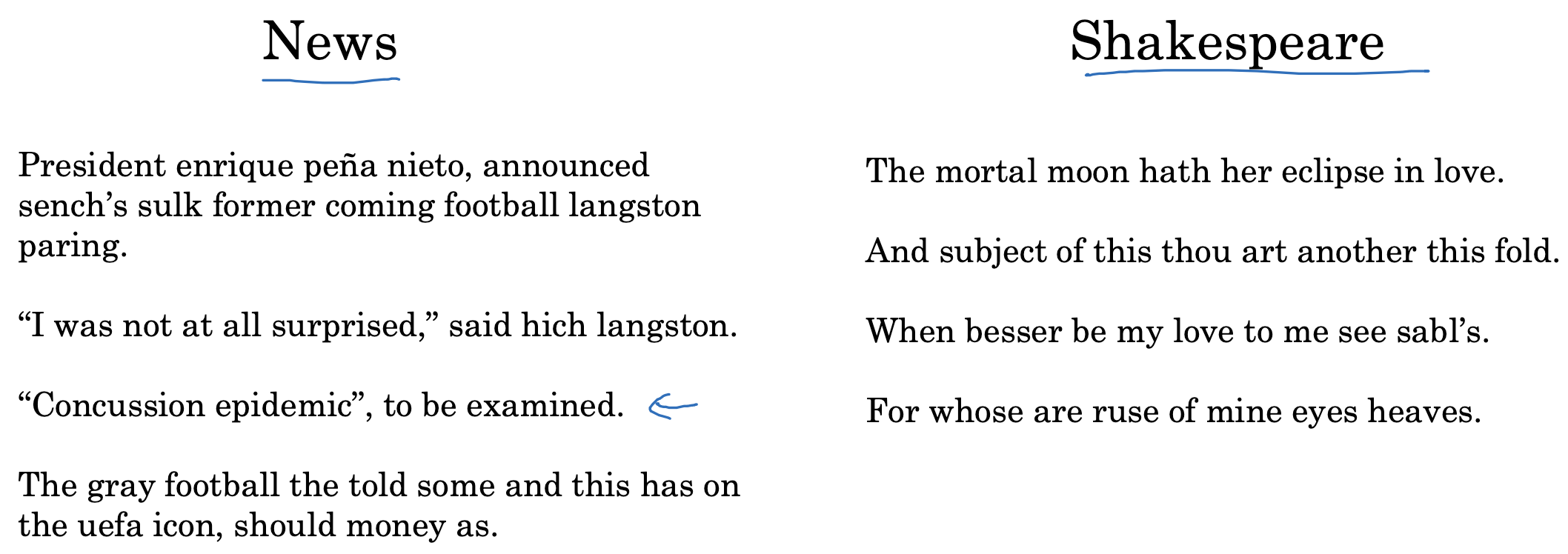

Sequence generation

출처: Coursera, Sequence Models, DeepLearning.AI

'Sequence Models > 1주차' 카테고리의 다른 글

| Recurrent Neural Networks(9) : Gated Recurrent Unit (GRU) (0) | 2023.04.17 |

|---|---|

| Recurrent Neural Networks(8) : Vanishing Gradients with RNNs (0) | 2023.04.14 |

| Recurrent Neural Networks(6) : Language Model and Sequence Generation (0) | 2023.04.14 |

| Recurrent Neural Networks(5) : Different Types of RNNs (0) | 2023.04.14 |

| Recurrent Neural Networks(4) : Backpropagation Through Time (0) | 2023.04.13 |