![]()

최근(2023.10)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success [Google DeepMind, Standford Univ] LLM의 reasoning process를 자동적으로 guide하는 analogical prompting를 제시. labeling 작업이 필요하지 않아 generality & convenience, 특정 problem에 적용 가능하여 adaptability. 배경 언어 모델을 학습할 때 CoT(Chain of Thought) 방식을 채택하는 것이 모델 성능 향상에 큰 도움이 된다는 것은 이미 잘 알려져 있습니다. 어떤 문제를 해결할 때 단순히 정답만을 반환하는 것이 아니라,..

![]()

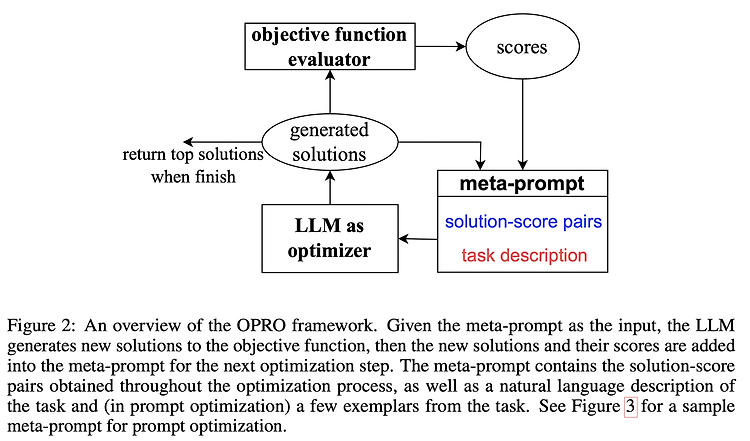

최근(2023.09)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success [Google DeepMind] LLM에 대해 Prompting 기술을 활용하여 Optimization 하는 OPRO를 제안. Linear Regression, Traveling Salesman Problem / GSM8K, Big-Bench Hard Task 배경 원래 optimization, 최적화라고 하면 주어진 문제를 풀기 위해 정의된 objective fuction에 대한 최적화를 뜻합니다. 목표로 설정한 함수를 최적화하는 것은 solution을 반복적으로 업데이트함으로써 달성됩니다. 지금까지는 어떤 방식으로 solution..

![]()

최근(2023.07)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success [Google DeepMind] attention layer가 key, value 쌍으로 이루어진 외부 메모리에 접근. 이를 통해 훨씬 더 긴 입력을 받을 수 있고, 여러 개의 문서에 대해 retrieval 할 수 있게 됨. 이 방식을 Focused Transforemr(FoT)라고 하며, OpenLLaMA(3B, 7B) 대상으로 tuning한 모델, LONGLLAMA를 공개. 배경 LLM은 그 능력이 엄청나지만 의외로 특정 분야에 한정된다는 문제점을 안고 있습니다. 엄청난 양의 데이터와 자원으로 한 번 학습되면, 이를 확장하는 것이..

![]()

최근(2023.06)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success [Google DeepMind] Generalized Knowledge Distillation(GKD)을 통해 기존 distillation이 마주한 한계를 극복. summarization, machine translation, arithmetic reasoning task로 검증 LLM이 가지는 능력을 사이즈가 작은 모델도 지닐 수 있도록 확률 분포 자체를 모방하듯이 학습하는 방식을 Knowledge Distillation(KD)이라고 부릅니다. 그러나 이 방식이 완벽한 것은 아니어서, ‘학습 시 배운 분포와 실제 생성하는 outpu..