Transformers Motivation

자연어처리 분야의 문제를 해결하기 위해 등장한 Transformer 아키텍쳐는 현재까지 인공지능 분야 전반에 엄청나게 큰 영향을 주었습니다.

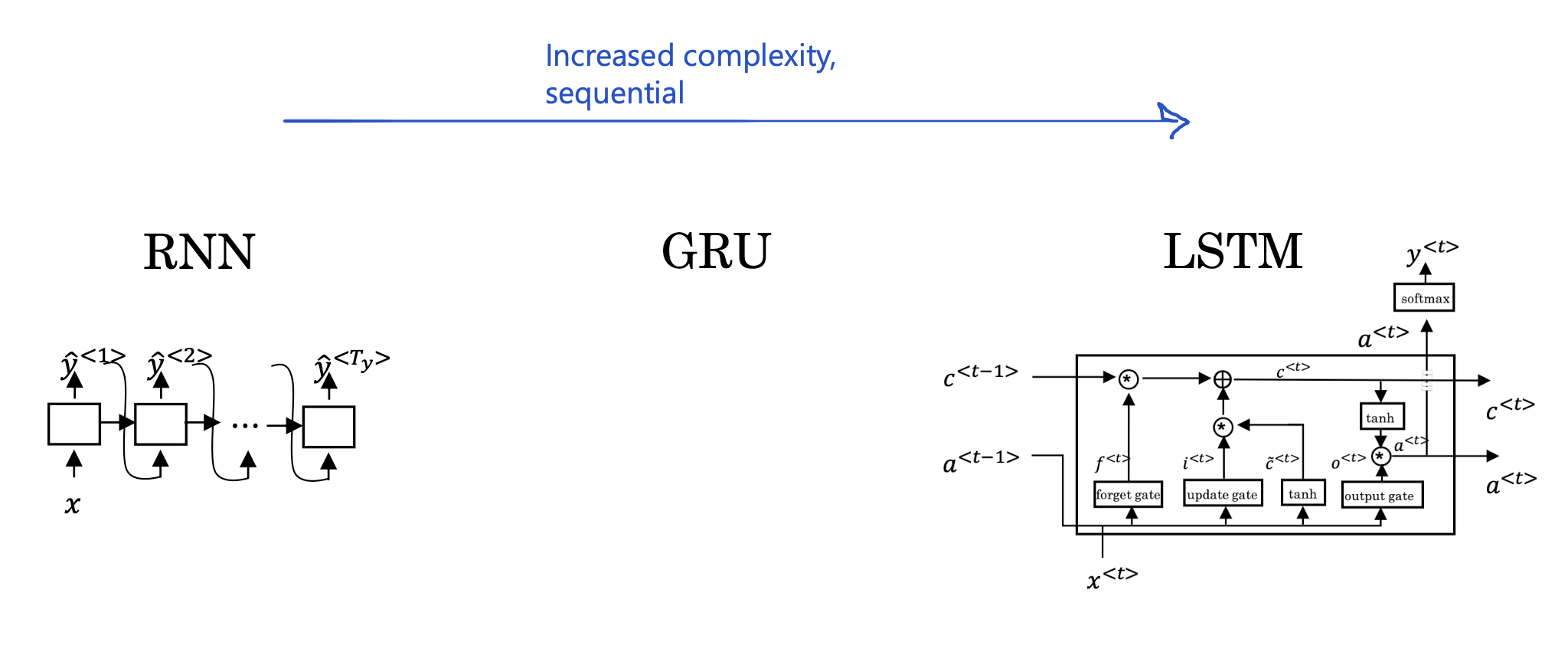

RNN, GRU, LSTM 등 다양한 sequence model들이 등장했지만,

sequence의 길이가 증가하면서 발생하는 문제점을 여전히 해결하지 못했죠.

Transformers Intuition

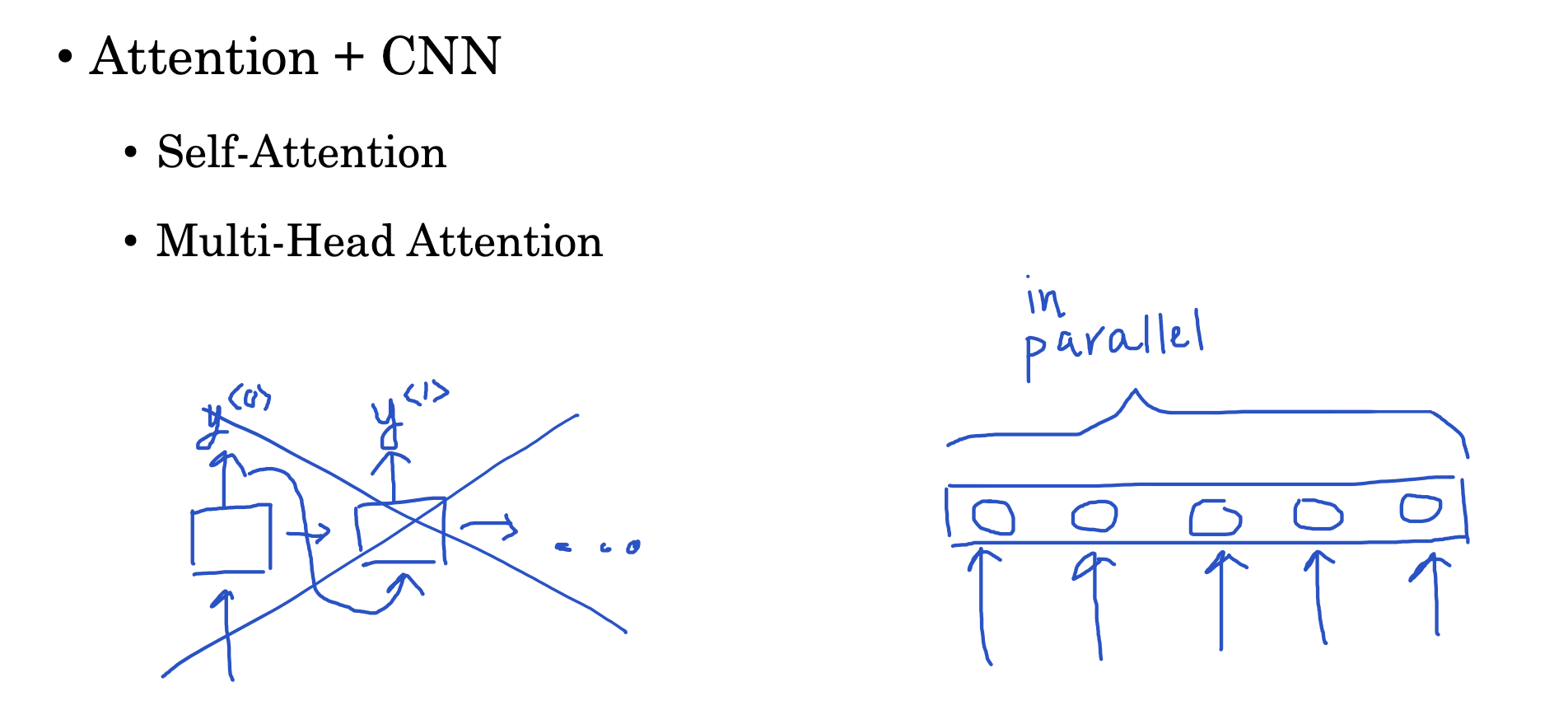

이러한 문제점을 해결하기 위해 등장한 Transformer는 attention 구조와 CNN 구조를 결합한 형태를 띠고 있습니다.

두 그림 중에서 우측처럼 한꺼번에 모든 입력 간의 관계를 계산하고 representation을 구하는 것이죠.

이때 사용되는 attention이 self-attention인데 sequence의 길이만큼 representation(표상)을 구한다는 특징이 있습니다.

출처: Coursera, Sequence Models, DeepLearning.AI

'Sequence Models > 4주차' 카테고리의 다른 글

| Transforemrs(4) : Transformer Network (0) | 2023.04.30 |

|---|---|

| Transformers(3) : Multi-Head Attention (0) | 2023.04.30 |

| Transformers(2) : Self-Attention (0) | 2023.04.30 |