관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. (Language & Knowledge Lab의 Retreival 관련)

혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️

[Microsoft Cognitive Service Research], ICLR 2023 conference paper

- GenRead, LLM이 question을 기반으로 contextual document를 생성하고, 최종 답변을 생성하기 위해 해당 document를 참조하는 방식

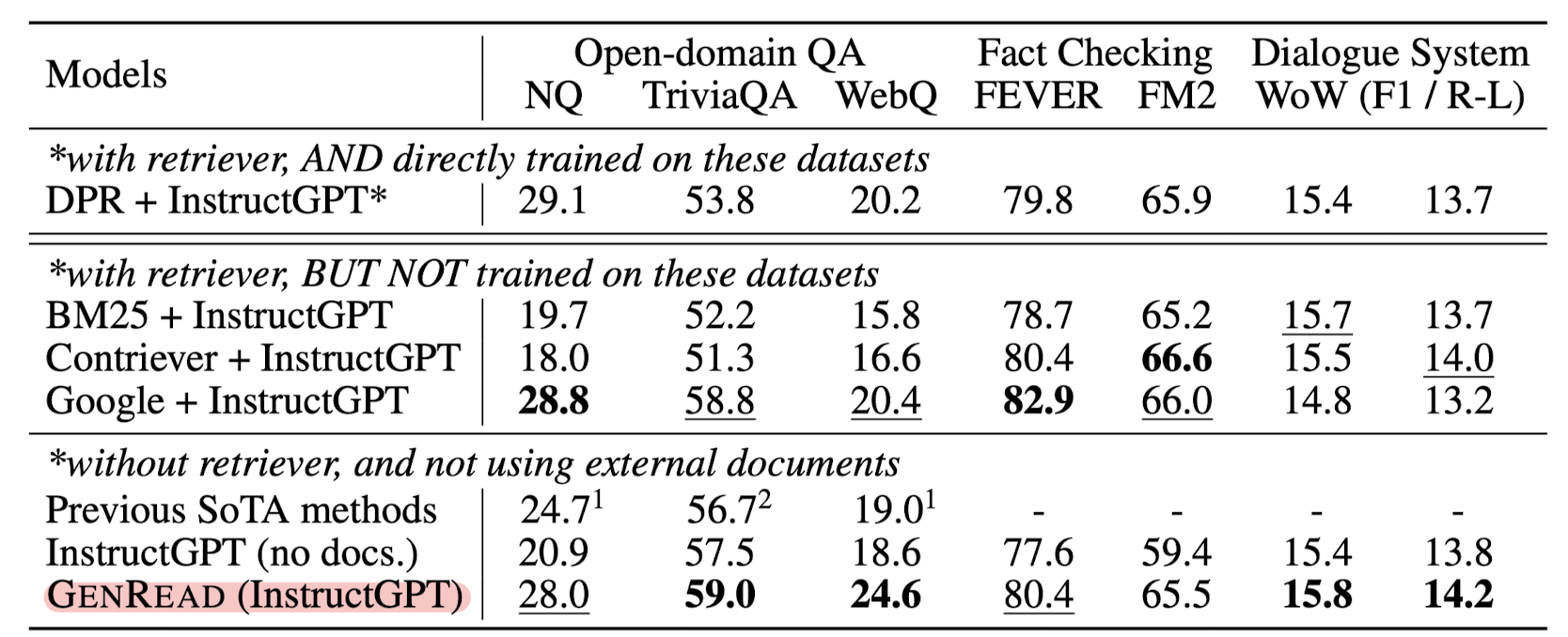

- 외부 knowledge source로부터 어떤 문서도 retrieve하지 않고 여러 태스크에서 SoTA 성능 달성

- retrieval & generation 형태로 결합도 가능

- 배경

- knowledge-intensive task를 처리하기 위해 기존에는 'retrieve-then-read' pipeline이 주로 쓰였으나 다음과 같은 문제점들이 존재

- 1) retrieval 대상이 되는 후보 document가 특정 단어 단위로 chunked & fixed 되어 있기 때문에 질문과 무관한 noise가 껴있을 수 있음

- 2) two-tower dense retrieval model을 사용하는 현재 방식으로는 question & document에 대한 representation이 독립적으로 획득됨

- 3) 거대한 corpus에 대한 document retrieval을 수행하기 위해서는 retriever model이 우선 모든 후보 document를 encode하고 각 document의 represnetation을 저장해야 함

- Related Works

- Knowledge-Intensive NLP via Retrieve-Then-Read Pipeline

- Generator as Retriever for Obtaining Contextual Documents

- NLP Models Enhanced by Large Language Model Outputs

- Contributions

- document를 retrieving하는 프로세스를 LLM이 관련 contextual document를 생성하는 방식으로 대체한, 'generate-then-read' pipeline을 제시

- 정답이 포함되어 있을 가능성을 높이는 contextual document를 다양하게, 그리고 여러 개 생성하는 'clustering-based prompting approach'를 제안

- 세 개의 knowledge-intensive NLP tasks에 대한 extensive experiments를 진행: under both zero shot and supvervised settings

- GenRead (Generate-then-Read)

- Zero-Shot Setting

- 기존 retrieve-then-read pipeline은 off-the-shelf retriever를 사용하여 relevant document를 가져오는 방식

- 본 연구에서는generated document variable d를 사용

- 1) LLM으로 주어진 question에 대한 document를 생성하도록 prompting -> 2) 생성된 sentence d hat을 input question과 함께 입력으로 주어서 LLM으로부터 final answer를 생성

- Supvervised Setting

- small reader model, FiD를 사용

- Diverse Human Prompts: human annotator가 다양한 prompt를 직접 생성

- 수고가 많이 들어가는 작업 & 각 LLM이 prompt words에 민감하게 반응

- Clustering-Based Prompts

- 1) Get One Inintial Document Per Question

- 2) Encode Each Document, Do K-means Clustering: Q개의 documents를 12,288차원 벡터로 변환 -> K-means clustering 적용

- 3) Sample and Generate K Documents: cluster c에서 n개의 sample을 뽑아 순서대로 묶어 입력으로 제공 -> K-generated documents 획득

- Zero-Shot Setting

- Benchmarks

- NQ, TriviaQA, WebQ, FEVER, FM2, WoW

- Metrics

- Exact Match (EM), Recall@K (R@K), Accuracy (ACC), F1 / Rouge-L (R-L)

출처 : https://arxiv.org/abs/2209.10063

Generate rather than Retrieve: Large Language Models are Strong Context Generators

Knowledge-intensive tasks, such as open-domain question answering (QA), require access to a large amount of world or domain knowledge. A common approach for knowledge-intensive tasks is to employ a retrieve-then-read pipeline that first retrieves a handful

arxiv.org