최근에 나온 논문을 읽어보고 간단히 정리했습니다.

혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️

[OpenAI]

LLM이 아직까지 취약한 모습을 보이는 수학 문제를 잘 풀게 할 수 있도록 새로운 데이터셋을 구축하고, 적절한 학습 방식에 대해 연구한 논문.

PRM800K 라는 데이터셋을 오픈 소스로 공개했으며 process supervision 방식이 효과적이라고 발표

최근의 경험과 주변 사람들의 이야기를 통해 LLM이 어지간해서는 수학 문제를 정상적으로 풀어내지 못한다는 것을 알게 되었습니다.

간단히 생각해보면 주어진 현재 상황에서 다음에 등장할 확률이 가장 높은 토큰을 예측하는 방식은 논리적인 이해를 바탕으로 하지 않는다는 것을 알 수 있죠.

그렇기 때문에 수학 문제처럼 multi-step이 중요하고 각 과정 간의 이해가 밑바탕이 되어야하는 태스크에서는 LLM이 약세를 보이는 것입니다.

이런 문제를 극복하기 위해서 본 논문의 실험을 통해 밝힌 중요한 사실은,

‘결과’보다는 ‘과정’ 자체를 학습하는 것이 모델의 성능 향상에 더 유의미한 영향을 준다는 것입니다.

이전만 하더라도 두 방식 간에 그다지 큰 차이가 없다고 알려져 있었지만, 이는 데이터의 수가 부족했기 때문이라고 밝혔습니다.

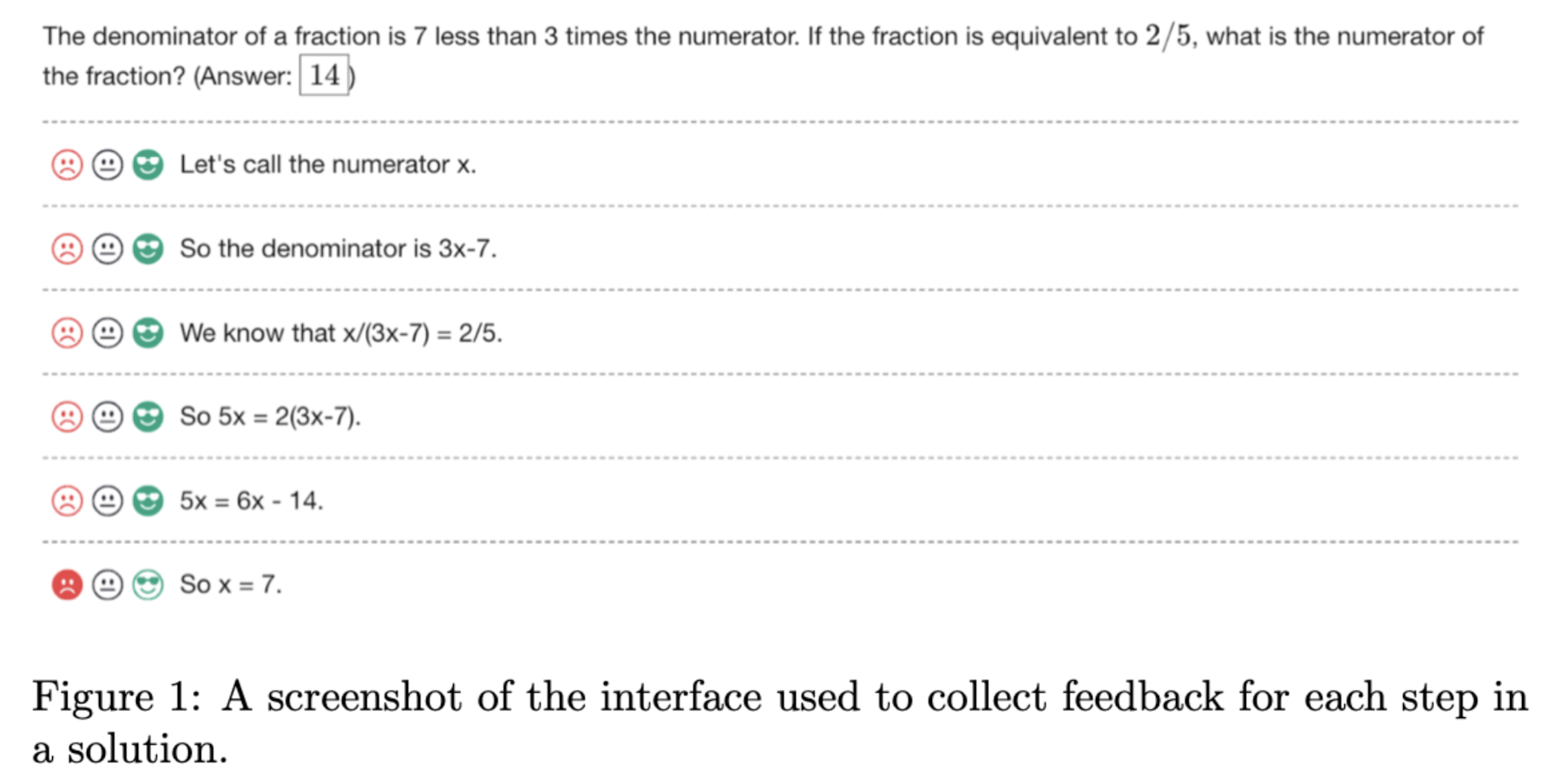

왜냐하면 ‘과정(process supervision)’을 학습하기 위해서는 각 과정이 문제 없이 잘 진행되고 있는지를 사람이 직접 판단하는 절차가 필요하기 때문입니다.

단순히 결과(outcome)만 옳고 그른지를 판단하는 것은 정해진 metric을 이용하여 자동화할 수 있지만 과정에 대해서는 그것이 불가능하죠.

하지만 역시 ChatGPT를 세상의 중심으로 만들어 놓은 OpenAI답게 이 과정에 대한 labeling에도 Human Feedback을 접목시켜 버렸습니다.

즉 사람들을 갈아 넣어서 multi-step reasoning이 제대로 되고 있는지를 평가하고, 이 데이터를 많이 모아서 모델을 학습시킨 것이 단순히 결과만을 가지고 학습한 모델보다 훨씬 우수한 성능을 보였다는 것입니다.

최근에는 OpenAI에서 연구 성과를 자세히 공개하지도 않고 결과물 자체만 자랑하는 식의 논문들을 냈었던 것으로 기억하는데,

이번에는 데이터셋도 공개하고 유의미한 실험 결과를 발표한 것 같아서 재밌게 읽었습니다.

개인적으로도 수학 문제를 푸는 AI를 만들어보는 것에 흥미가 조금 있는데(자원상의 한계로 인해 도전이 쉽지는 않을 것으로 보입니다만 🥲) 결국 데이터인가..! 싶은 생각이 들었습니다.

출처 : https://arxiv.org/abs/2305.20050?utm_source=substack&utm_medium=email

Let's Verify Step by Step

In recent years, large language models have greatly improved in their ability to perform complex multi-step reasoning. However, even state-of-the-art models still regularly produce logical mistakes. To train more reliable models, we can turn either to outc

arxiv.org

'Paper Review' 카테고리의 다른 글

최근에 나온 논문을 읽어보고 간단히 정리했습니다.

혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️

[OpenAI]

LLM이 아직까지 취약한 모습을 보이는 수학 문제를 잘 풀게 할 수 있도록 새로운 데이터셋을 구축하고, 적절한 학습 방식에 대해 연구한 논문.

PRM800K 라는 데이터셋을 오픈 소스로 공개했으며 process supervision 방식이 효과적이라고 발표

최근의 경험과 주변 사람들의 이야기를 통해 LLM이 어지간해서는 수학 문제를 정상적으로 풀어내지 못한다는 것을 알게 되었습니다.

간단히 생각해보면 주어진 현재 상황에서 다음에 등장할 확률이 가장 높은 토큰을 예측하는 방식은 논리적인 이해를 바탕으로 하지 않는다는 것을 알 수 있죠.

그렇기 때문에 수학 문제처럼 multi-step이 중요하고 각 과정 간의 이해가 밑바탕이 되어야하는 태스크에서는 LLM이 약세를 보이는 것입니다.

이런 문제를 극복하기 위해서 본 논문의 실험을 통해 밝힌 중요한 사실은,

‘결과’보다는 ‘과정’ 자체를 학습하는 것이 모델의 성능 향상에 더 유의미한 영향을 준다는 것입니다.

이전만 하더라도 두 방식 간에 그다지 큰 차이가 없다고 알려져 있었지만, 이는 데이터의 수가 부족했기 때문이라고 밝혔습니다.

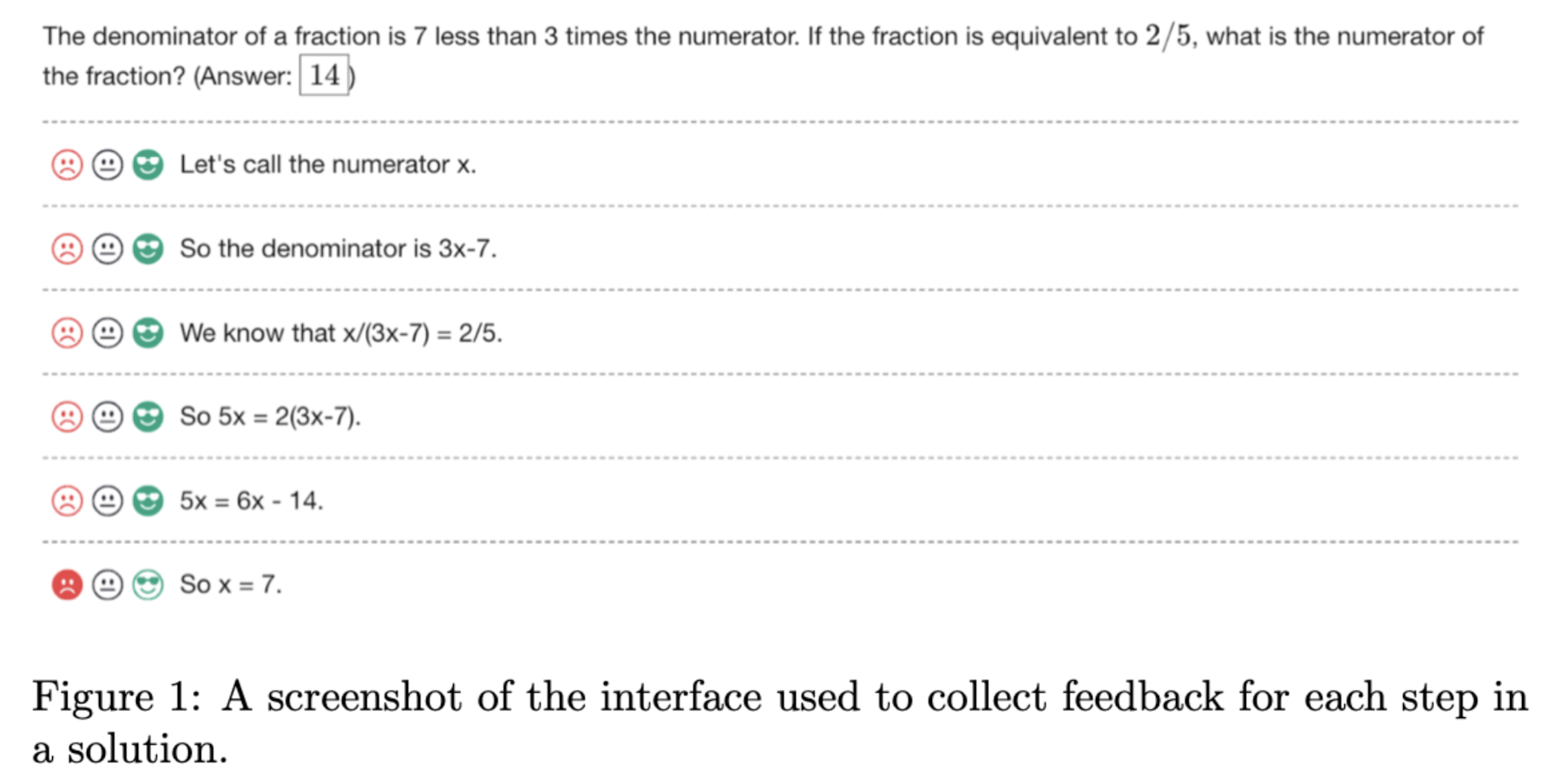

왜냐하면 ‘과정(process supervision)’을 학습하기 위해서는 각 과정이 문제 없이 잘 진행되고 있는지를 사람이 직접 판단하는 절차가 필요하기 때문입니다.

단순히 결과(outcome)만 옳고 그른지를 판단하는 것은 정해진 metric을 이용하여 자동화할 수 있지만 과정에 대해서는 그것이 불가능하죠.

하지만 역시 ChatGPT를 세상의 중심으로 만들어 놓은 OpenAI답게 이 과정에 대한 labeling에도 Human Feedback을 접목시켜 버렸습니다.

즉 사람들을 갈아 넣어서 multi-step reasoning이 제대로 되고 있는지를 평가하고, 이 데이터를 많이 모아서 모델을 학습시킨 것이 단순히 결과만을 가지고 학습한 모델보다 훨씬 우수한 성능을 보였다는 것입니다.

최근에는 OpenAI에서 연구 성과를 자세히 공개하지도 않고 결과물 자체만 자랑하는 식의 논문들을 냈었던 것으로 기억하는데,

이번에는 데이터셋도 공개하고 유의미한 실험 결과를 발표한 것 같아서 재밌게 읽었습니다.

개인적으로도 수학 문제를 푸는 AI를 만들어보는 것에 흥미가 조금 있는데(자원상의 한계로 인해 도전이 쉽지는 않을 것으로 보입니다만 🥲) 결국 데이터인가..! 싶은 생각이 들었습니다.

출처 : https://arxiv.org/abs/2305.20050?utm_source=substack&utm_medium=email

Let's Verify Step by Step

In recent years, large language models have greatly improved in their ability to perform complex multi-step reasoning. However, even state-of-the-art models still regularly produce logical mistakes. To train more reliable models, we can turn either to outc

arxiv.org