최근(2023.06)에 나온 논문을 읽어보고 간단히 정리했습니다.

혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️

[Univ. of Washington]

여러 개의 reward 모델을 사용하고, 생성 문장 전체가 아닌 개별 문장에 피드백을 줘서 학습하는 것이 경제적이고 더 효율적이라고 주장하는 논문

- 배경

대중들에게도 AI가 친숙해지는데 가장 큰 공헌을 한 것은 RLHF(Reinforcement Learning with Human Feedback)이 아닐까 싶습니다.

이 덕분에 ChatGPT가 정말 ‘사람처럼’ 응답하고 품질이 우수한 답변을 내놓을 수 있게 되었으니까요.

그런데 본 논문에서는 기존의 RLHF 방식의 한계점을 지적하고 있습니다.

생성된 전체 output에 대해 ranking을 부여하는 방식으로는, 모델의 입장에서 어떤 부분이 잘못되었고 개선해야하는 부분인지를 파악하기 어렵기 때문이라는 것을 근거로 삼습니다.

물론 데이터의 양이 어마무시하게 많다면 이런 한계도 극복할 수 있을 것처럼 보이지만, 최근 연구 트렌드가 최적화나 경량화에 초점이 맞춰진 것들이 많다는 점을 생각해보면 충분히 납득이 가는 상황입니다.

어쨌든 이런 한계를 극복하기 위해서는 output 전체가 아닌, 문장 단위의 feedback이 주어져야 하고, 이 feedback도 ranking이 아닌, category별로(3개) 주어져야 한다고 주장합니다.

- 컨셉 및 실험 결과

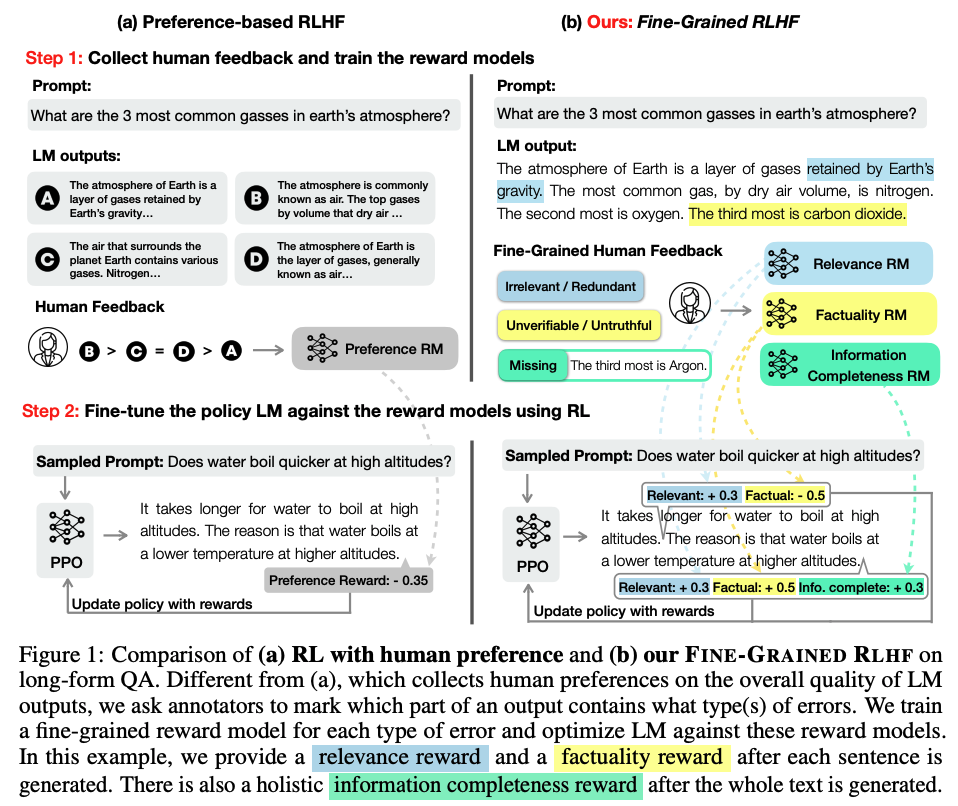

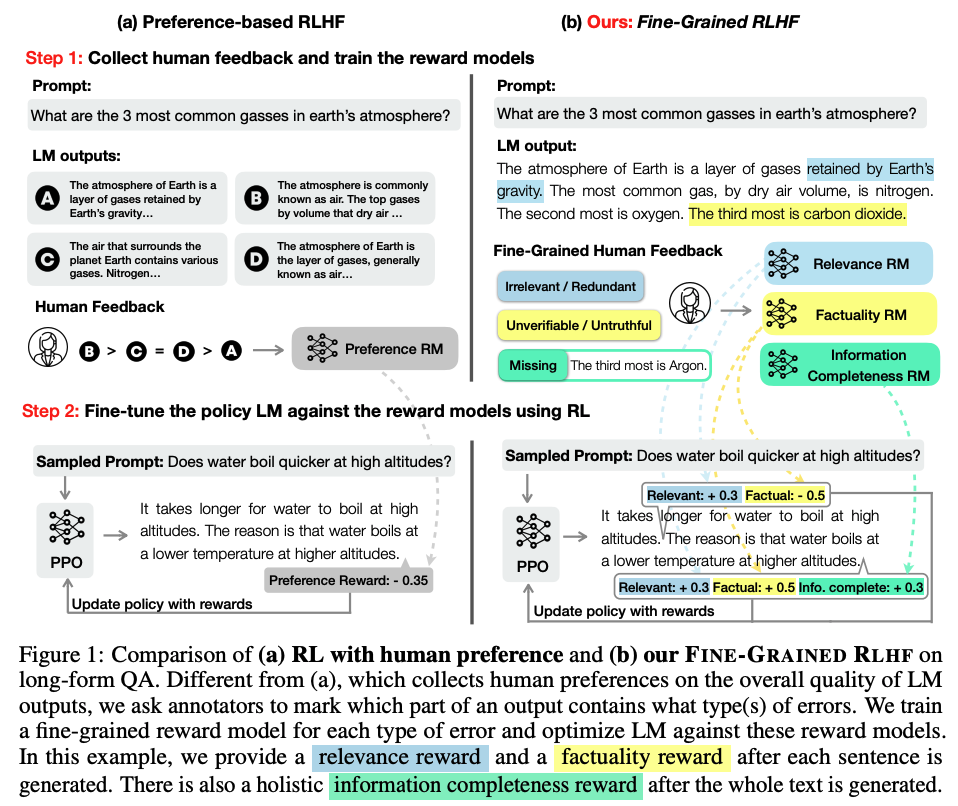

이전의 RLHF 방식(좌)과 Fined-Graind RLHF(우)를 비교한 그림입니다.

그림에서 볼 수 있는 것처럼 Fine-Grained RLHF는 크게 세 가지 카테고리가 있습니다.

- C1 : irrelevance, repetition, and incoherence

- C2 : incorrect or unverifiable facts

- C3 : incomplete information

output을 이루는 여러 문장을 하나씩 살피면서 어떤 카테고리에 해당하는 오류인지 확인합니다.

각 오류는 다른 카테고리와 중첩될 수 없고, 특히 C3로 판정되었다면 올바른 답을 제시해야 합니다.

이는 기존에 여러 개의 완성된 output을 전부 살펴보고 그 중에서 우위를 정하는 방식에 비해 오히려 annotation 시간이 줄어드는 방식이라고 합니다.

특히 사람이 완벽한 output을 새로 만들어줘야 하는 경우 시간이 더 많이 걸리게 되는 것이죠.

어쨌든 세 개의 카테고리를 기준으로 세 개의 Reward 모델이 학습한 결과를 바탕으로 보다 구체적인 가이드를 모델에게 제시해줄 수 있습니다.

본 논문에서는 Detoxification과 Long-From Questions Answering, 두 태스크로 모델의 성능을 확인했고, 결과적으로 기존의 RLHF 방식에 비해 더 좋은 퍼포먼스를 보였다는 것을 입증했습니다.

- 개인적 감상

👍🏻

예전에 LLM의 출력 결과 대신 출력을 유도하기 까지의 과정을 CoT처럼 뽑아내고, 이를 학습하도록 한 방식에 대해 공부한 적이 있는데, 이와 굉장히 유사하다는 생각이 들었습니다.

아주 최근에도 ‘Let’s Verify Step by Step’이라는 OpenAI 논문을 읽으면서 output supervision보다 process supervision 방식이 모델 학습에 효과적이라는 내용을 봤었는데 이것과도 일맥상통하는 내용같습니다.

결국 지금에 이르러 LLM이 사람들의 마음에 굉장히 잘 fit하는 것에 Human Feedback 핵심적인 영향을 주었고, 단순히 결과론적인 피드백을 넘어선 절차적인 피드백이 사람들의 마음에 더 잘 맞는 모델을 만드는데 일조하고 있지 않나 싶습니다.

👎🏻

다만 저자가 언급한 바와 같이 Reward 모델이 도메인이나 태스크의 종류에 영향을 크게 받을 수밖에 없다는 점이 한계점으로 느껴집니다.

예를 들면 C2 : incorrect or unverifialbe facts의 경우 Long-Form Questions Answering과 관련이 깊습니다.

쉽게 말하면 데이터 베이스를 기반으로 해당 정보를 찾을 수 있는지, 그리고 그 정보가 정확한지를 확인하는 것입니다.

하지만 이런 카테고리에 해당하지 않는 Math Word Problem Solving 등의 태스크에는 적합한 Reward 기준이 될 수 없을 것입니다.

따라서 태스크마다 적합한 모델링을 해야할지도 모르는 방식이라는 점이 이러한 접근의 가장 큰 한계점이라고 볼 수 있겠습니다.

출처 : https://arxiv.org/abs/2306.01693?utm_source=substack&utm_medium=email

Fine-Grained Human Feedback Gives Better Rewards for Language Model Training

Language models (LMs) often exhibit undesirable text generation behaviors, including generating false, toxic, or irrelevant outputs. Reinforcement learning from human feedback (RLHF) - where human preference judgments on LM outputs are transformed into a l

arxiv.org

'Paper Review' 카테고리의 다른 글

최근(2023.06)에 나온 논문을 읽어보고 간단히 정리했습니다.

혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️

[Univ. of Washington]

여러 개의 reward 모델을 사용하고, 생성 문장 전체가 아닌 개별 문장에 피드백을 줘서 학습하는 것이 경제적이고 더 효율적이라고 주장하는 논문

- 배경

대중들에게도 AI가 친숙해지는데 가장 큰 공헌을 한 것은 RLHF(Reinforcement Learning with Human Feedback)이 아닐까 싶습니다.

이 덕분에 ChatGPT가 정말 ‘사람처럼’ 응답하고 품질이 우수한 답변을 내놓을 수 있게 되었으니까요.

그런데 본 논문에서는 기존의 RLHF 방식의 한계점을 지적하고 있습니다.

생성된 전체 output에 대해 ranking을 부여하는 방식으로는, 모델의 입장에서 어떤 부분이 잘못되었고 개선해야하는 부분인지를 파악하기 어렵기 때문이라는 것을 근거로 삼습니다.

물론 데이터의 양이 어마무시하게 많다면 이런 한계도 극복할 수 있을 것처럼 보이지만, 최근 연구 트렌드가 최적화나 경량화에 초점이 맞춰진 것들이 많다는 점을 생각해보면 충분히 납득이 가는 상황입니다.

어쨌든 이런 한계를 극복하기 위해서는 output 전체가 아닌, 문장 단위의 feedback이 주어져야 하고, 이 feedback도 ranking이 아닌, category별로(3개) 주어져야 한다고 주장합니다.

- 컨셉 및 실험 결과

이전의 RLHF 방식(좌)과 Fined-Graind RLHF(우)를 비교한 그림입니다.

그림에서 볼 수 있는 것처럼 Fine-Grained RLHF는 크게 세 가지 카테고리가 있습니다.

- C1 : irrelevance, repetition, and incoherence

- C2 : incorrect or unverifiable facts

- C3 : incomplete information

output을 이루는 여러 문장을 하나씩 살피면서 어떤 카테고리에 해당하는 오류인지 확인합니다.

각 오류는 다른 카테고리와 중첩될 수 없고, 특히 C3로 판정되었다면 올바른 답을 제시해야 합니다.

이는 기존에 여러 개의 완성된 output을 전부 살펴보고 그 중에서 우위를 정하는 방식에 비해 오히려 annotation 시간이 줄어드는 방식이라고 합니다.

특히 사람이 완벽한 output을 새로 만들어줘야 하는 경우 시간이 더 많이 걸리게 되는 것이죠.

어쨌든 세 개의 카테고리를 기준으로 세 개의 Reward 모델이 학습한 결과를 바탕으로 보다 구체적인 가이드를 모델에게 제시해줄 수 있습니다.

본 논문에서는 Detoxification과 Long-From Questions Answering, 두 태스크로 모델의 성능을 확인했고, 결과적으로 기존의 RLHF 방식에 비해 더 좋은 퍼포먼스를 보였다는 것을 입증했습니다.

- 개인적 감상

👍🏻

예전에 LLM의 출력 결과 대신 출력을 유도하기 까지의 과정을 CoT처럼 뽑아내고, 이를 학습하도록 한 방식에 대해 공부한 적이 있는데, 이와 굉장히 유사하다는 생각이 들었습니다.

아주 최근에도 ‘Let’s Verify Step by Step’이라는 OpenAI 논문을 읽으면서 output supervision보다 process supervision 방식이 모델 학습에 효과적이라는 내용을 봤었는데 이것과도 일맥상통하는 내용같습니다.

결국 지금에 이르러 LLM이 사람들의 마음에 굉장히 잘 fit하는 것에 Human Feedback 핵심적인 영향을 주었고, 단순히 결과론적인 피드백을 넘어선 절차적인 피드백이 사람들의 마음에 더 잘 맞는 모델을 만드는데 일조하고 있지 않나 싶습니다.

👎🏻

다만 저자가 언급한 바와 같이 Reward 모델이 도메인이나 태스크의 종류에 영향을 크게 받을 수밖에 없다는 점이 한계점으로 느껴집니다.

예를 들면 C2 : incorrect or unverifialbe facts의 경우 Long-Form Questions Answering과 관련이 깊습니다.

쉽게 말하면 데이터 베이스를 기반으로 해당 정보를 찾을 수 있는지, 그리고 그 정보가 정확한지를 확인하는 것입니다.

하지만 이런 카테고리에 해당하지 않는 Math Word Problem Solving 등의 태스크에는 적합한 Reward 기준이 될 수 없을 것입니다.

따라서 태스크마다 적합한 모델링을 해야할지도 모르는 방식이라는 점이 이러한 접근의 가장 큰 한계점이라고 볼 수 있겠습니다.

출처 : https://arxiv.org/abs/2306.01693?utm_source=substack&utm_medium=email

Fine-Grained Human Feedback Gives Better Rewards for Language Model Training

Language models (LMs) often exhibit undesirable text generation behaviors, including generating false, toxic, or irrelevant outputs. Reinforcement learning from human feedback (RLHF) - where human preference judgments on LM outputs are transformed into a l

arxiv.org