관심있는 최신 NLP 논문을 읽어보고 간단히 정리했습니다.

혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️

[Singapore University]

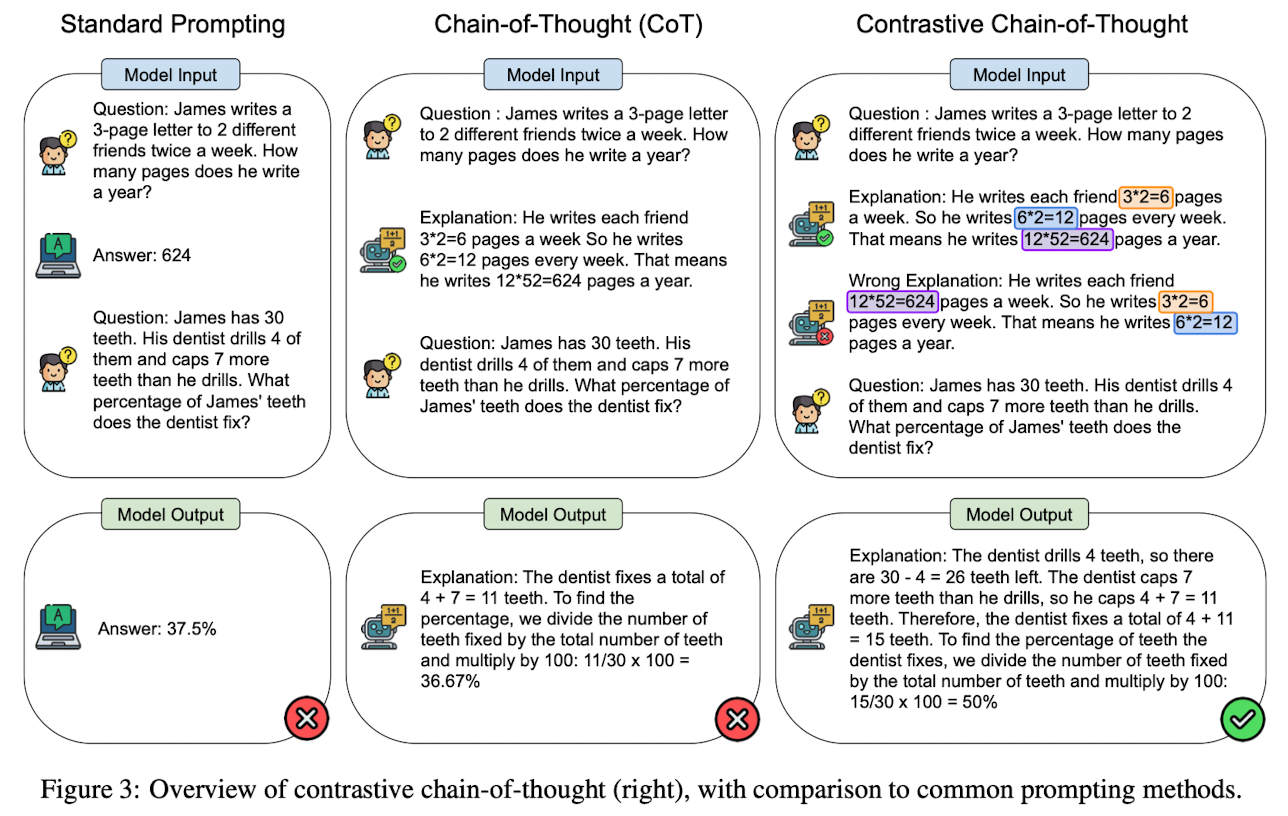

- valid & invalid reasoning demonstrations을 함께 제공하여 reasoning mistakes를 줄이는 approach, Contrastive Chain-of-Thought

- contrastive demonstration을 자동적으로 구축하는 방법을 제시

- 배경

- LLM과 관련하여 모델 사이즈를 키우는 것만으로는 complex reasoning tasks에 대한 좋은 일반화 성능을 기대하기 어려움

- invalid reasoning demonstration을 포함하는 것이 reasoning 성능에 영향을 주지 않는다는 결과

- 한편으로는 중간 step이 모델의 추론 결과에 큰 영향을 줄 수 있다는 선행 연구도 존재

- Related Works

- Large Language Models (LLM)

- 모델의 사이즈와 학습 데이터를 massively scaling

- 추가적인 학습 없이 LM을 이용하는 패러다임 등장

- 수학적 추론, 사실 기반 QA 등에 대해서는 여전히 약한 모습

- Chain of Thought (CoT)

- intermediate step을 생성함으로써 LM을 enhance

- automatic CoT, Let's think step-by-step

- 메커니즘 기저에 대한 온전한 이해는 여전히 부족

- Large Language Models (LLM)

-

- Learning from Negative Examples

- invalid demonstration이 추론 과정에 유용한지에 대해서는 아직 확인된 바가 없음

- contrastive learning, RLHF 등에 negative samples를 활용

- Learning from Negative Examples

- Contributions

- positive & negative demonstrations을 결합하여 Chain-of-Thought의 효과를 극대화

- Contrastive Chain-of-Thought를 위해 contrastive demonstrations 구축을 자동화하는 방식 제안

- 여러 reasoning benchmarks에 대한 평가를 통해 해당 방식의 효용 입증

- Effect of Different Types of Contrastive Demonstrations

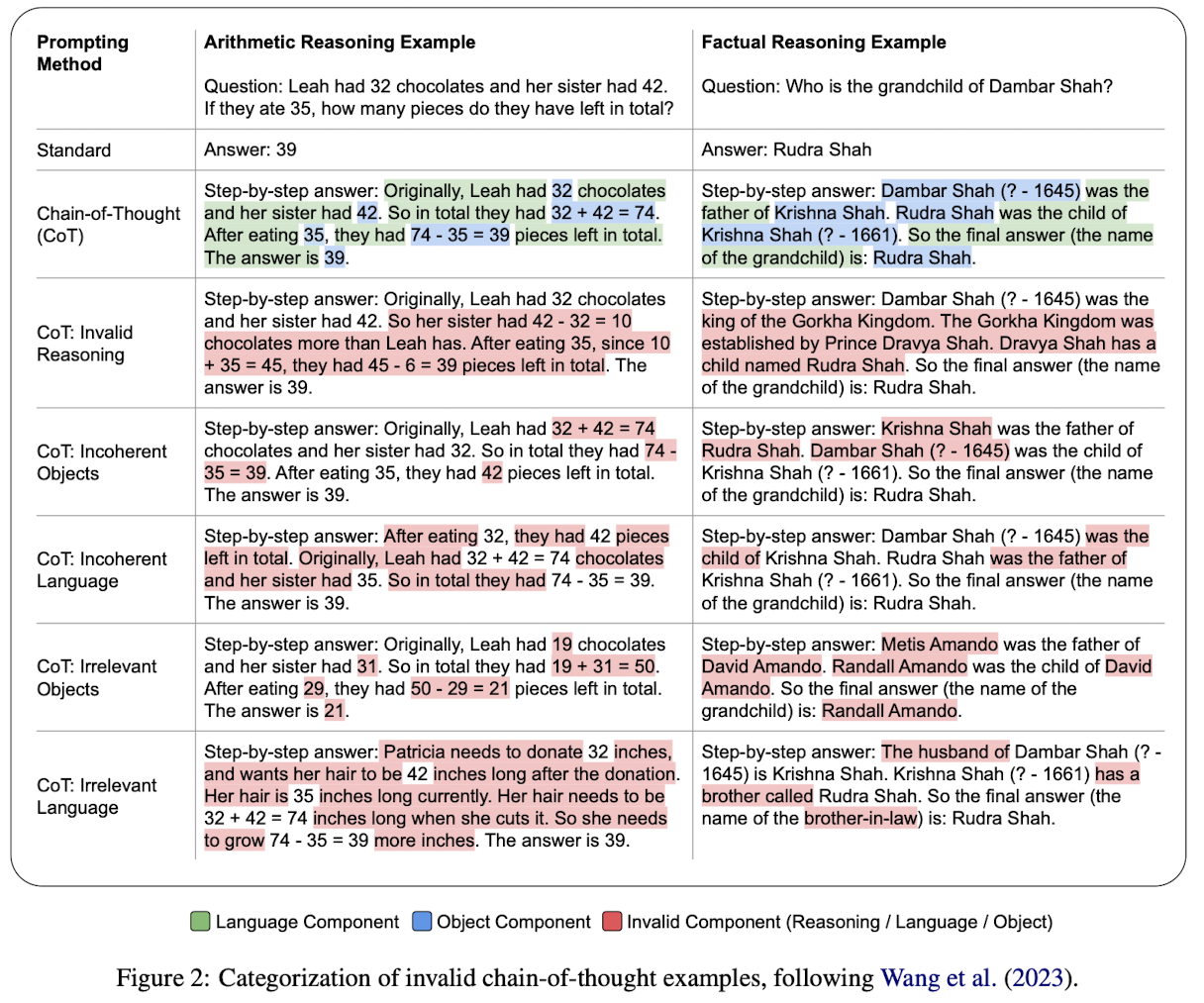

- Components of Chain of Thought

- Bridging objects: 숫자나 방정식 또는 entity의 이름 등 상징적 item을 뜻함

- Language templates: 언어 모델이 reasoning process 동안 올바른 bridging objects를 contextualize할 수 있도록 하는 textual hints

- What is Invalid Chain of Thought?

- Coherence: rationale의 step 순서가 일관적으로 유지되는가

- Relevance: rationale이 질문에 대답하기 위해 필요한 정보를 담고 있는가

- Experimental Setup

- GSM8K, Bamboogle 벤치마크에 대해 GPT-3.5-Turbo (0301) version을 사용

- 다섯 개의 invalid categories에 대한 평가

- 간소화된 chain-of-thought prompt 포맷을 사용

- Preliminary Results

- 모든 invalid rationale 카테고리에 대해 기존 CoT 대비 상당한 진전이 있음

- 특히 incoherent objects를 포함하는 contrastive demonstration을 활용하는 것이 가장 효과가 좋음

- Components of Chain of Thought

- Contrastive Chain of Thought

- Preliminary Results를 통해 Contrastive Chain of Tought 방식이 의미있음을 확인했으나, 이를 일일이 작성하는 것은 비효율적이므로 이를 자동화하는 방식을 제안

- 특히 효과가 좋았던 'incoherent objects' 방식을 취하되, (Query, T+, A+, T-, A-) 포맷을 갖춤. 이때 T는 reasoing step을 A는 answer를 뜻함. (기존은 Q, T, A)

- Incoherent Objects를 만들기 위해서 entity recognition model을 사용하여 numbers, equations, persons를 추출하고 각 position을 shuffle

- Benchmark

- Arithmetic Reasoning: GSM8K, AQuA, GSM-Hard, SVAMP, ASDIV

- Factual Question Answering: Bamboogle, StreategyQA

- Results

- Contrastive CoT가 기존 CoT 대비 arithmetic & factual reasoning에서 둘 다 우위

- Contrastive CoT는 self-consistency와 함께 적용되면 더욱 효과적

출처 : https://arxiv.org/abs/2311.09277

Contrastive Chain-of-Thought Prompting

Despite the success of chain of thought in enhancing language model reasoning, the underlying process remains less well understood. Although logically sound reasoning appears inherently crucial for chain of thought, prior studies surprisingly reveal minima

arxiv.org