![]()

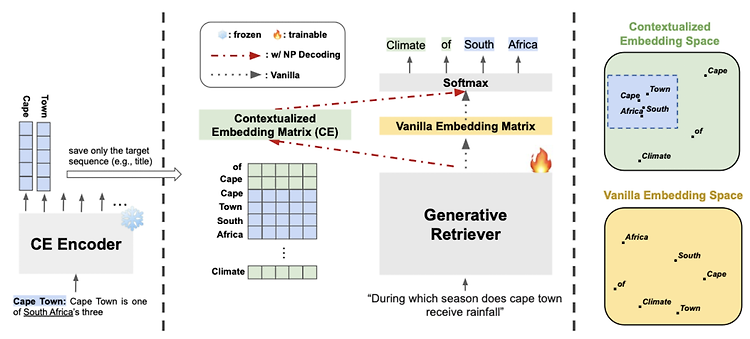

관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. (Language & Knowledge Lab의 Retreival 관련) 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ [KAIST AI, Kakao] - 현존하는 generative retrieval model에 모두 적용 가능한 Nonparametric Decoding (Np Decoding)을 제안 - Np Decoding은 nonparametric contextualized vocab embedding (external memory)를 사용 배경 Text Retrieval에서 bi-encoder를 사용하는 방식은 embedding space bottleneck과 large storage space 문제가 존재 최근 인기를 끌고..

![]()

관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. (Language & Knowledge Lab의 Retreival 관련) 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ [RAG] Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks (2021.04) [Facebook AI Research] - parametric memory는 사전학습된 seq2seq, non-parametric momory는 위키피디아의 dense vector index - 하나의 retrieved passage로 sequence 전체를 생성하는 방식 vs 각 토큰별로 다른 retrieved passage를 참고하는 방식� 배경 사전학습된 Neural..

![]()

관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. (Language & Knowledge Lab의 Retreival 관련) 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ [LK Lab] - Language Model은 블랙박스 취급하고 tuneable retrieval model로 증강 효과를 누리는 Retrieval-Augmented Language Modeling Framework, REPLUG - frozen 블랙박스 LM에 retrieved documents를 prepend하는 방식 - LM은 retrieval model을 supervise하는 데 활용될 수 있음 LLM은 뛰어난 능력을 가지고 있지만 hallucination을 보이거나 long tail에 해당하는 knowle..

![]()

관심 있는 NLP 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success [KAIST AI] - multi-hop 태스크에서 기존의 bi-encoder 방식이 지닌 한계를 입증 - retrieval target이 되는 text sequence 전체를 생성함으로써 multi-hop retrieval 태스크를 수행 - GPU memory & Storage footprint 효율성이 높음 배경 text retrieval 문제는 지금까지 주로 query와 관련성이 높은 paragraph 또는 document 하나를 찾는 것에 집중해왔음 이를 위해서 query와 retrieval sequence 둘 다 공통의 vector s..

![]()

관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. (Language & Knowledge Lab의 Retreival 관련) 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ [Evaluation] Exploring the Benfits of Training Expert Language Models over Instruction Tuning (2023.02) [Minjoon Seo] - 단 하나의 task에 대해 fine-tuned된 expert LM이 300개 이상의 task로 학습된 MT (multitask-prompted fine-tuning) LM을 outperform - distributed approach의 장점: avoiding negative task transfer, co..

![]()

관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. (Language & Knowledge Lab의 Retreival 관련) 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success [Evaluation] Prometheus: Inducing Fine-Grained Evaluation Capability in Language Models (2023.10) [KAIST, Naver AI, University of Washington, MIT] - GPT-4의 평가 수준에 준하는 완전한 오픈소스 LLM, Prometheus - customized score rubric 기반으로 long-form text를 평가할 수 있는 13B 사이즈의 평가자 LLM, P..