![]()

관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success [Microsoft, Israel] - LLM이 사전학습 동안 보지 못했던 정보를 추가 습득하도록 하는 방식 중 fine-tuning과 retrieval-augmented generation (RAG)를 비교 - 두 방식 중에서 RAG가 훨씬 성능이 좋은 것으로 확인됨. 심지어 base with RAG > fine-tuned with RAG 1. Introduction LLM은 다양한 도메인의 지식을 보유하고 있음이 잘 알려져 있으나 여전히 명확한 한계가 존재함 static하다, 즉 새로운 정보가 업데이트 되지 않는다 특수한 도메인의 전문 지식은..

![]()

관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success [Apple] - query에 explicit information이 부족한 경우 retrieval 성능 향상에 도움이 되는 Context Tuning for RAG를 제안 - LambdaMART에 Reciprocal Rank Fusion (RRF)를 적용한 lightweight 모델이 GPT-4 기반 retireval보다 뛰어남 1. Introduction 다양한 태스크를 두루 잘 처리할 수 있는 LLM의 능력 덕분에, LLM을 planning agent로 활용하고자 하는 연구가 활발히 이뤄짐 최신 정보가 반영되지 않는 등의 inherent l..

![]()

관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. (Language & Knowledge Lab의 Retreival 관련) 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ [RAG] Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks (2021.04) [Facebook AI Research] - parametric memory는 사전학습된 seq2seq, non-parametric momory는 위키피디아의 dense vector index - 하나의 retrieved passage로 sequence 전체를 생성하는 방식 vs 각 토큰별로 다른 retrieved passage를 참고하는 방식� 배경 사전학습된 Neural..

![]()

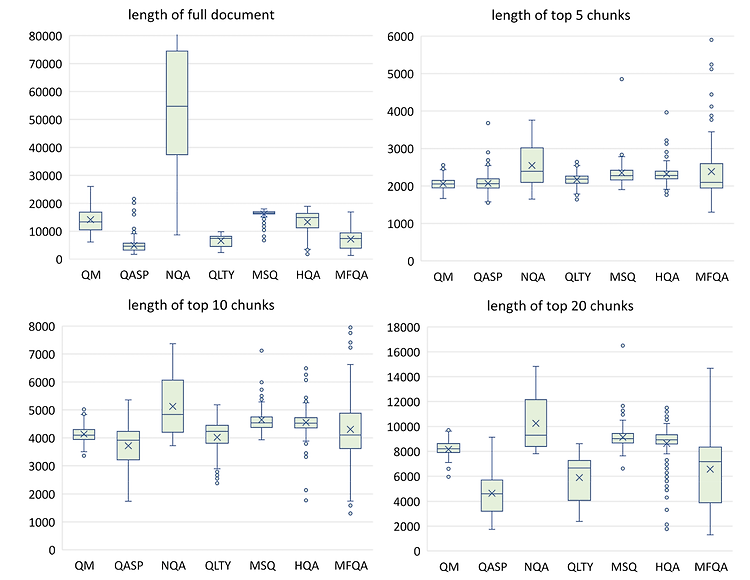

최근(2023.10)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success [NVIDIA] LLM with 4k context window + simple retrieval-augmentation → LLM with 16K context window 심지어 더 큰 윈도의 사이즈를 가진 더 큰 모델에 retrieval-augmentation을 적용해도 성능이 향상됨. 배경 LLM의 능력을 최대한 활용하기 위해 더 긴 길이의 텍스트를 모델이 처리할 수 있게끔 하는 연구들이 활발하게 이뤄지고 있습니다. 그중에서도 최근에는 모델의 입력 길이 자체를 확장하는 'long context window'에 관한 연구와 입력..