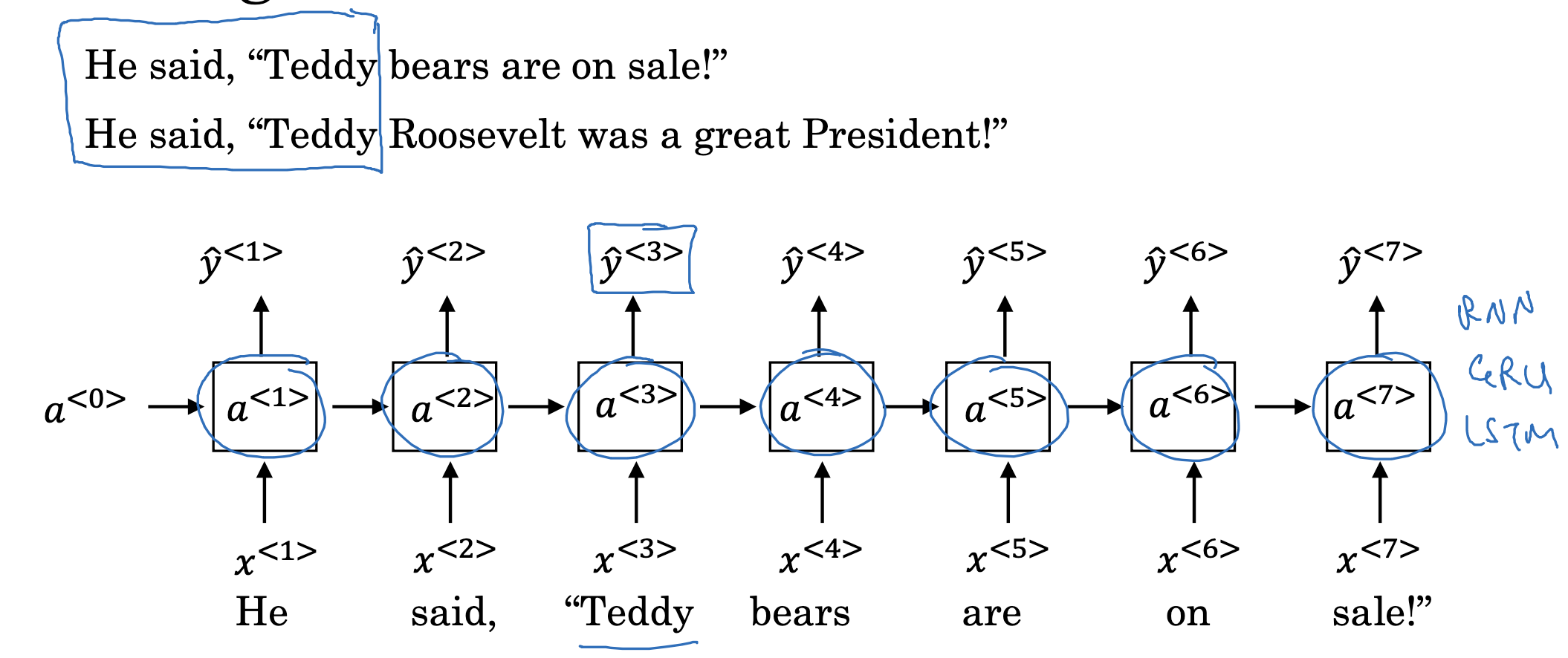

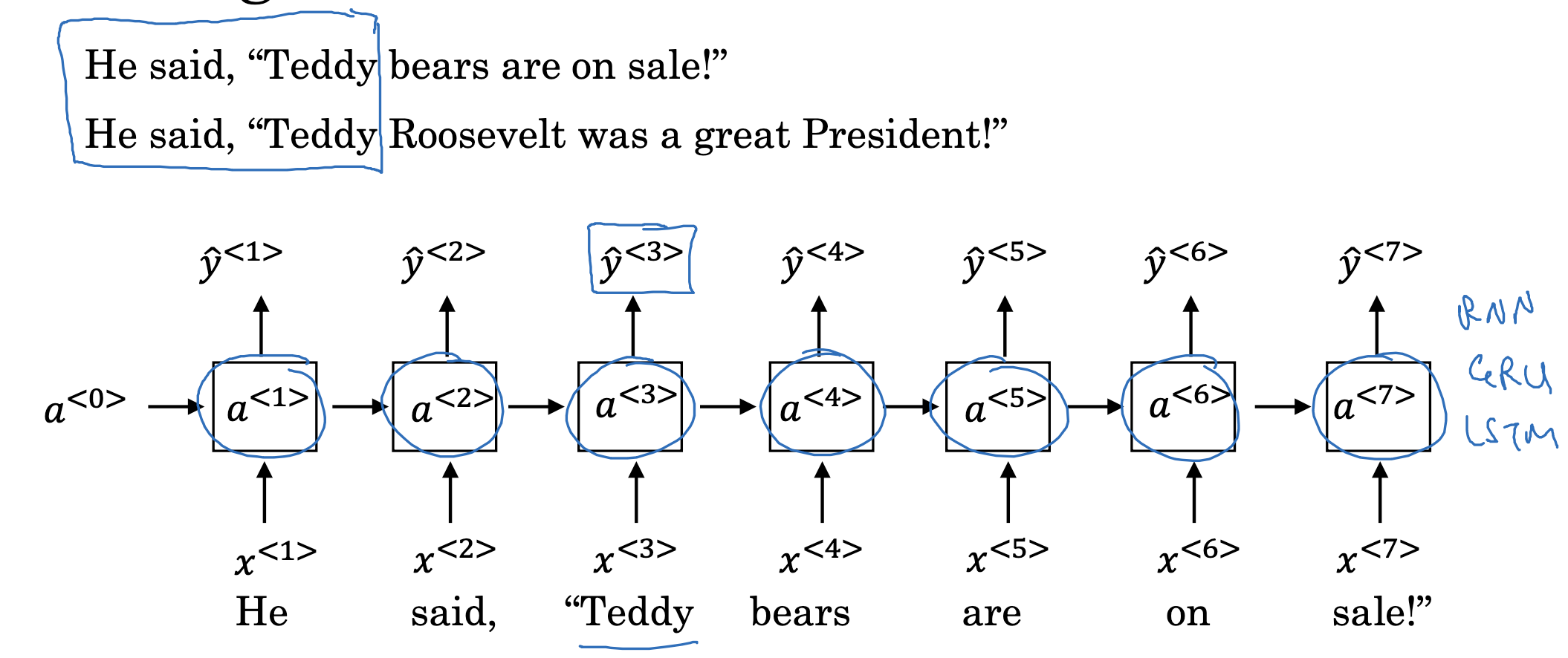

Getting information from the future

- 지금까지 살펴본 RNN, GRN, LSTM과 같은 모델들은 입력 정보를 계산하여 forward하는 방식으로만 문제를 처리하고 있습니다.

- 그에 따라서 이후의 정보를 반영하는 것이 중요한 위 예시같은 문제는 해결하지 못한다는 문제점을 안고 있죠.

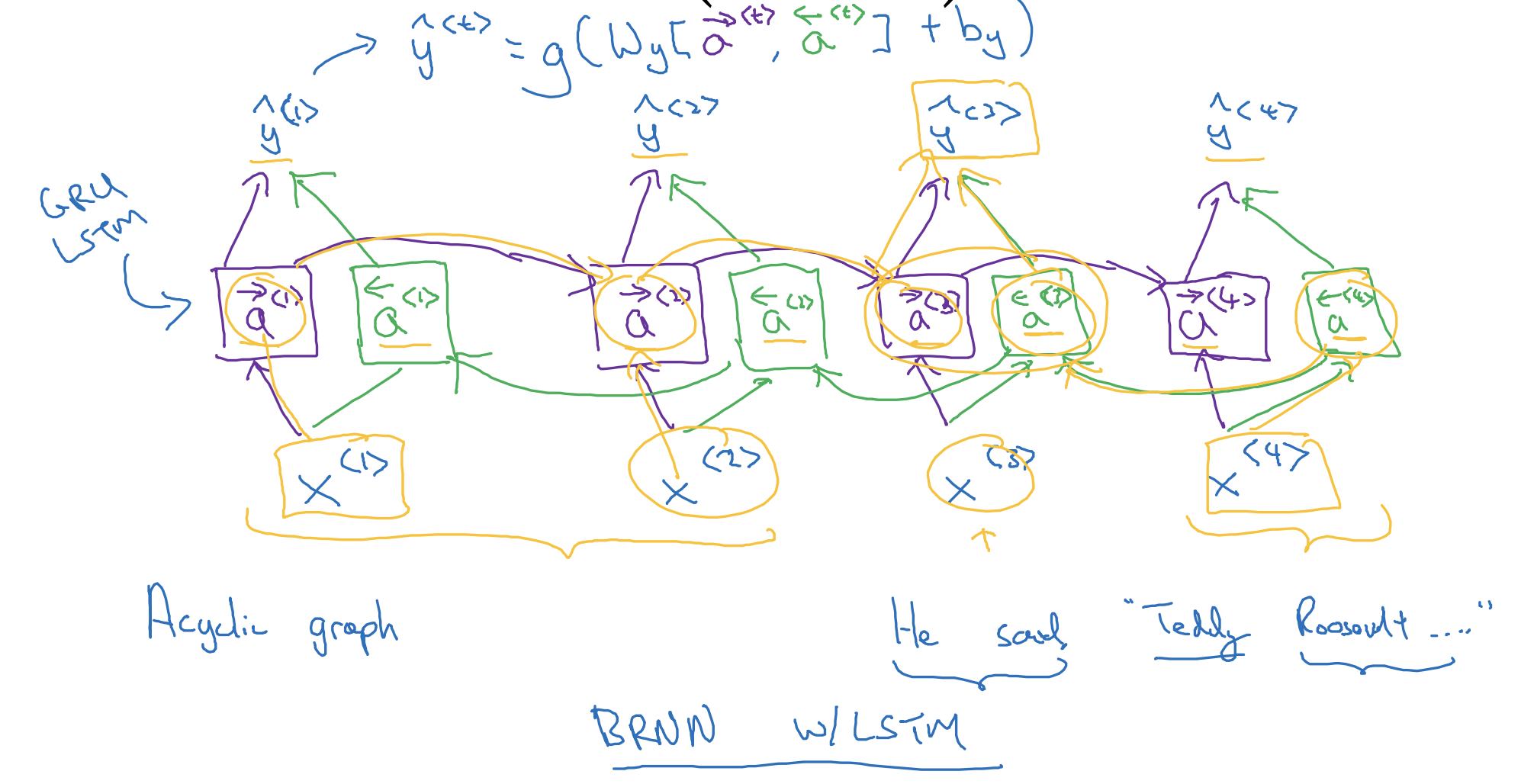

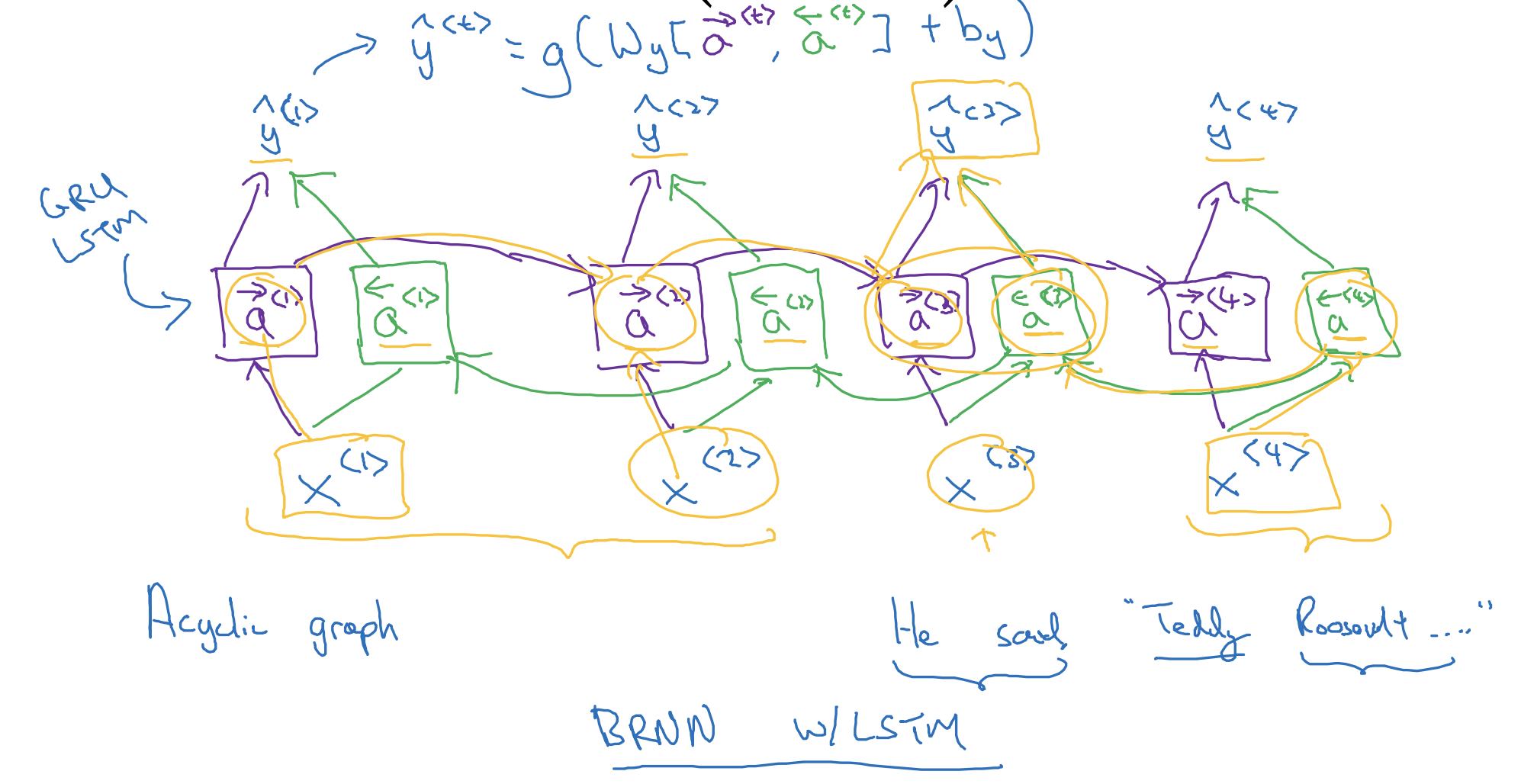

Bidirectional RNN (BRNN)

- Bidirectional RNN은 위처럼 forward 뿐만 아니라 backward 방향의 정보도 함께 반영하여 예측값을 구합니다.

그래서 예시의 경우 Teddy라는 일부의 정보만으로 다음 단어를 예측하지 않게 되어 보다 정확한 예측이 가능해집니다. - 물론 음성 인식처럼 이전 정보만을 가지고 다음 값을 예측해야 하는 경우에는 적합하지 않지만, 대부분의 자연어 처리 태스크에 대해서는 우수한 성능을 보여줍니다.

출처: Coursera, Sequence Models, DeepLearning.AI

'Sequence Models > 1주차' 카테고리의 다른 글

| Recurrent Neural Networks(12) : Deep RNNs (0) | 2023.04.17 |

|---|---|

| Recurrent Neural Networks(10) : Long Short Term Memory (LSTM) (0) | 2023.04.17 |

| Recurrent Neural Networks(9) : Gated Recurrent Unit (GRU) (0) | 2023.04.17 |

| Recurrent Neural Networks(8) : Vanishing Gradients with RNNs (0) | 2023.04.14 |

| Recurrent Neural Networks(7) : Sampling Novel Sequences (0) | 2023.04.14 |

Getting information from the future

- 지금까지 살펴본 RNN, GRN, LSTM과 같은 모델들은 입력 정보를 계산하여 forward하는 방식으로만 문제를 처리하고 있습니다.

- 그에 따라서 이후의 정보를 반영하는 것이 중요한 위 예시같은 문제는 해결하지 못한다는 문제점을 안고 있죠.

Bidirectional RNN (BRNN)

- Bidirectional RNN은 위처럼 forward 뿐만 아니라 backward 방향의 정보도 함께 반영하여 예측값을 구합니다.

그래서 예시의 경우 Teddy라는 일부의 정보만으로 다음 단어를 예측하지 않게 되어 보다 정확한 예측이 가능해집니다. - 물론 음성 인식처럼 이전 정보만을 가지고 다음 값을 예측해야 하는 경우에는 적합하지 않지만, 대부분의 자연어 처리 태스크에 대해서는 우수한 성능을 보여줍니다.

출처: Coursera, Sequence Models, DeepLearning.AI

'Sequence Models > 1주차' 카테고리의 다른 글

| Recurrent Neural Networks(12) : Deep RNNs (0) | 2023.04.17 |

|---|---|

| Recurrent Neural Networks(10) : Long Short Term Memory (LSTM) (0) | 2023.04.17 |

| Recurrent Neural Networks(9) : Gated Recurrent Unit (GRU) (0) | 2023.04.17 |

| Recurrent Neural Networks(8) : Vanishing Gradients with RNNs (0) | 2023.04.14 |

| Recurrent Neural Networks(7) : Sampling Novel Sequences (0) | 2023.04.14 |