최근에 나온 논문을 읽어보고 간단히 정리했습니다.

혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️

하나의 embedding에 여섯 개의 modality(image, text, audio, depth, thermal, IMU)가 공유되는 모델. 이를 위해서 이미지와 짝을 이루는 데이터만 있어도 충분하다.

- 배경

하나의 이미지에 다른 modality에 대한 여러 정보가 담길 수 있다는 것은 이미 잘 알려져 있습니다.

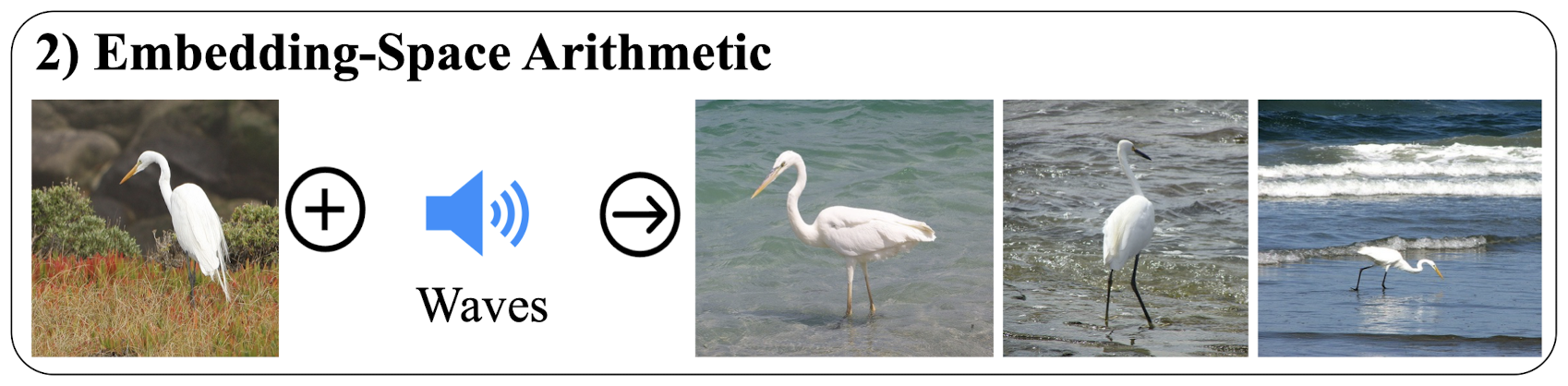

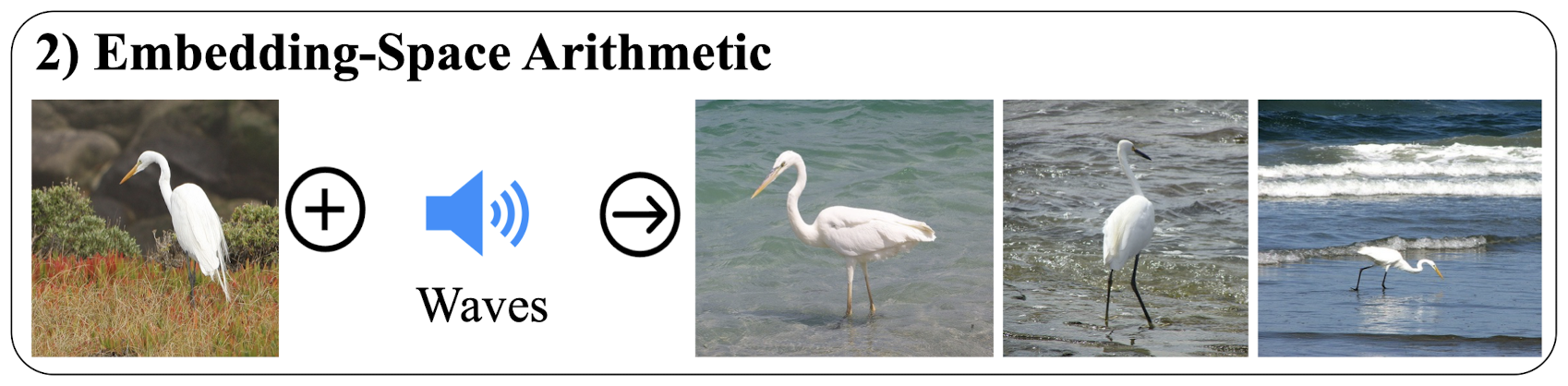

이미지와 소리를 결합한 예시 중 하나는 다음과 같습니다.

현재는 이뿐만 아니라 이미지와 텍스트 등 두 개의 modality를 짝지어 학습하는 경우가 적지 않습니다.

그러나 이러한 종류의 학습용 데이터는 분명히 한정되어 있기 때문에(label을 만드는 데 큰 비용이 들어갈 것으로 보입니다), 특정 데이터 종류로 학습된 모델이 다양한 modality에 대해서도 우수한 성능을 보이게 만들면 좋겠죠.

image-text 쌍 데이터가 충분히 많다면 이것이 가능하다고 주장하는 논문입니다.

- 컨셉

각각의 modality를 다른 encoder로 embedding합니다.

(이때 사용되는 encoder는 transformer 기반입니다)

이렇게 구한 embedding들을 image embedding에 align해줍니다.

image를 나타내는 I, 다른 modality를 나타내는 M으로 기호화하면 L(I,M)이 됩니다.

align은 쌍방향적인 것이기 때문에 loss를 구할 때는 L(I,M)과 L(M,I)를 더해줍니다.

- 개인적 감상

👍🏻

확실히 메타가 메타했다는 생각이 들었습니다.

물론 개인적인 수준에서 이뤄질 수 없는 사이즈의 연구여서 그렇기도 하지만, 이런 파격적인 내용을 담은 기술을 오픈 소스로 공개하는 것이 정말 대단하다는 생각이 듭니다.

(이름과 상반되는 태도를 지닌 모 기업과는 굉장히 다른 것 같죠?)

지금까지는 modality가 다른 경우는 두 개로 쌍을 이루는 것에 대해서만 생각했었는데, 이를 여러 개로 확장하고 또 유의미한 성과를 만들어 낸 점이 굉장히 인상 깊습니다.

어쨌든 이미지 중심으로 학습이 이뤄지고, 논문에서 언급되는 modality도 그와 관련된 것들이기 때문에 이를 제외한 다른 modality들에 대해서는 어떨지 궁금합니다.

👎🏻

여러 개의 modality들이 학습되지 않았음에도 불구하고 짝을 이루어 좋은 퍼포먼스를 보인다는 것은 분명히 대단합니다.

그러나 세 개 이상의 modality를 다루는 실험을 왜 하지 않았는지에 대해서는 의문이 남습니다.

항상 두 개로 짝이 이뤄져 있던 멀티 모달 분야에서 세 개 이상을 다루게 된 상황에서는, 분명히 여러 개를 조합하는 것이 파격적인 성과를 보여주는 가장 확실한 방법이었을텐데 말이죠.

물론 현존하는 벤치마크 중에 이런 태스크를 위한 것은 존재하지 않겠지만.. 이정도의 발표를 할 메타라면 충분히 가능하지 않았을까 싶은 생각이 들어서, 뭔가 이 부분에 대해서는 아쉬운 결과가 나왔기에 굳이 싣지 않은 것이 아닐까 상상이 되기도 하네요 ㅋㅋㅋ

'Paper Review' 카테고리의 다른 글

최근에 나온 논문을 읽어보고 간단히 정리했습니다.

혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️

하나의 embedding에 여섯 개의 modality(image, text, audio, depth, thermal, IMU)가 공유되는 모델. 이를 위해서 이미지와 짝을 이루는 데이터만 있어도 충분하다.

- 배경

하나의 이미지에 다른 modality에 대한 여러 정보가 담길 수 있다는 것은 이미 잘 알려져 있습니다.

이미지와 소리를 결합한 예시 중 하나는 다음과 같습니다.

현재는 이뿐만 아니라 이미지와 텍스트 등 두 개의 modality를 짝지어 학습하는 경우가 적지 않습니다.

그러나 이러한 종류의 학습용 데이터는 분명히 한정되어 있기 때문에(label을 만드는 데 큰 비용이 들어갈 것으로 보입니다), 특정 데이터 종류로 학습된 모델이 다양한 modality에 대해서도 우수한 성능을 보이게 만들면 좋겠죠.

image-text 쌍 데이터가 충분히 많다면 이것이 가능하다고 주장하는 논문입니다.

- 컨셉

각각의 modality를 다른 encoder로 embedding합니다.

(이때 사용되는 encoder는 transformer 기반입니다)

이렇게 구한 embedding들을 image embedding에 align해줍니다.

image를 나타내는 I, 다른 modality를 나타내는 M으로 기호화하면 L(I,M)이 됩니다.

align은 쌍방향적인 것이기 때문에 loss를 구할 때는 L(I,M)과 L(M,I)를 더해줍니다.

- 개인적 감상

👍🏻

확실히 메타가 메타했다는 생각이 들었습니다.

물론 개인적인 수준에서 이뤄질 수 없는 사이즈의 연구여서 그렇기도 하지만, 이런 파격적인 내용을 담은 기술을 오픈 소스로 공개하는 것이 정말 대단하다는 생각이 듭니다.

(이름과 상반되는 태도를 지닌 모 기업과는 굉장히 다른 것 같죠?)

지금까지는 modality가 다른 경우는 두 개로 쌍을 이루는 것에 대해서만 생각했었는데, 이를 여러 개로 확장하고 또 유의미한 성과를 만들어 낸 점이 굉장히 인상 깊습니다.

어쨌든 이미지 중심으로 학습이 이뤄지고, 논문에서 언급되는 modality도 그와 관련된 것들이기 때문에 이를 제외한 다른 modality들에 대해서는 어떨지 궁금합니다.

👎🏻

여러 개의 modality들이 학습되지 않았음에도 불구하고 짝을 이루어 좋은 퍼포먼스를 보인다는 것은 분명히 대단합니다.

그러나 세 개 이상의 modality를 다루는 실험을 왜 하지 않았는지에 대해서는 의문이 남습니다.

항상 두 개로 짝이 이뤄져 있던 멀티 모달 분야에서 세 개 이상을 다루게 된 상황에서는, 분명히 여러 개를 조합하는 것이 파격적인 성과를 보여주는 가장 확실한 방법이었을텐데 말이죠.

물론 현존하는 벤치마크 중에 이런 태스크를 위한 것은 존재하지 않겠지만.. 이정도의 발표를 할 메타라면 충분히 가능하지 않았을까 싶은 생각이 들어서, 뭔가 이 부분에 대해서는 아쉬운 결과가 나왔기에 굳이 싣지 않은 것이 아닐까 상상이 되기도 하네요 ㅋㅋㅋ