최근에 나온 논문을 읽어보고 간단히 정리했습니다.

혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️

GPT를 다양한 AI 모델들을 연결해주고 최적화된 하이퍼 파라미터를 제공해주는 수단으로 이용하는 방식을 제안한 논문

- 배경

LLM의 뛰어난 능력이 세간의 주목을 받게 되면서 여러 인공지능 모델을 통합하고자 하는 시도도 활발히 이뤄지고 있습니다.

그러나 말 그대로 거대한 사이즈의 모델들을 다루기 위해서는 굉장히 많은 자원이 필요하고, 각 태스크에 적합한 모델들을 어떻게 선정할 것인지가 명료하게 정리되기는 쉽지 않죠.

따라서 LLM을 통해 각 모델, 그리고 모델이 학습한 데이터에 대한 설명을 바탕으로 태스크에 적합한 모델을 선정하여 결과를 산출하는 방식을 적용해 볼 수 있습니다.

LLM은 데이터 처리, 아키텍쳐 디자인, 태스크에 적합한 실험 수행 등을 해줍니다.

- 컨셉

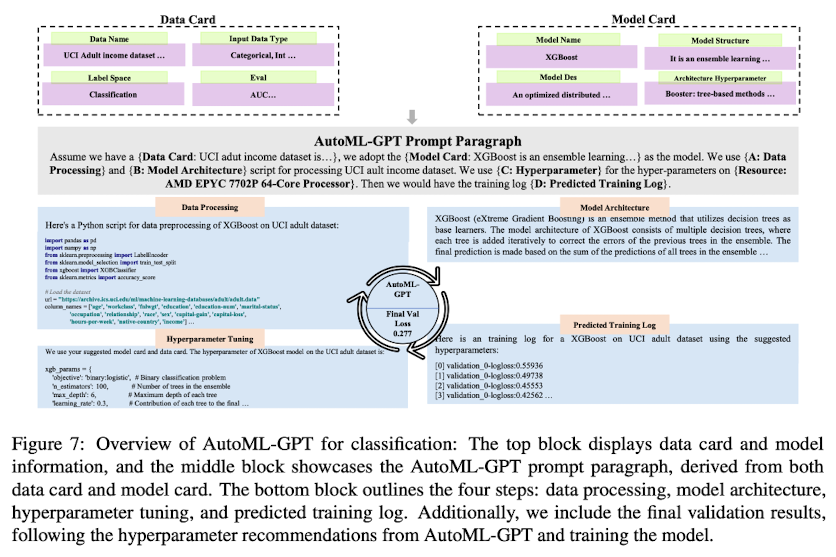

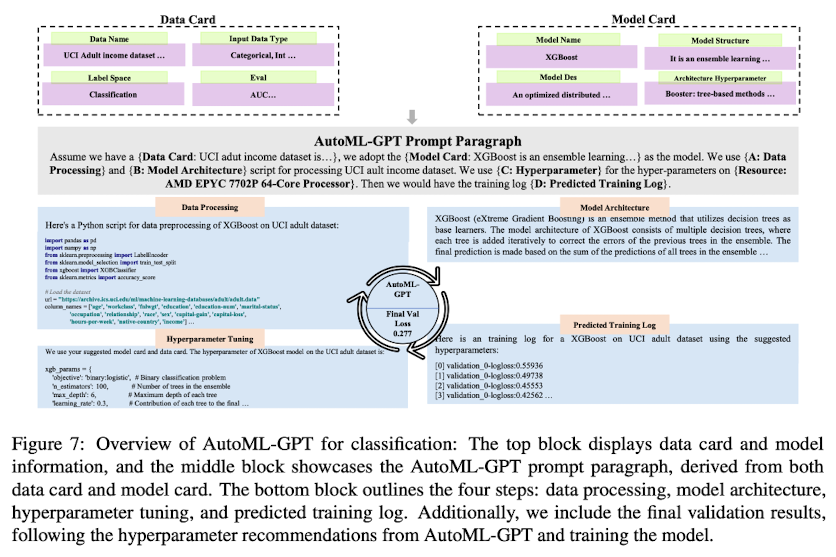

AutoML-GPT는 1) 모델/데이터 카드를 해석해 고정된 형태의 프롬프트 문단을 생성하고 2) 유저의 요청에 적합한 학습 파이프라인을 구축하여 3) 학습 로그를 생성한 뒤 4) 하이퍼 파라미터 튜닝을 진행합니다.

- 데이터 카드 : data name, input data type, label space, evaluation metric

- 모델 카드 : model name, model structure, model description, architecture hyperparameter

- 하이퍼 파라미터 튜닝 : 두 카드 정보를 바탕으로 학습 로그를 예측하여 생성하고 그 결과를 토대로 적절한 하이퍼 파라미터를 제안

- Unseen Datasets : 이전에 학습 경험이 없는 데이터셋에 대해서도 description으로부터의 상관관계를 통해 기학습된 결과를 전이할 수 있음

- 개인적 감상

👍🏻

최근 많은 사람들의 관심을 받았던 HuggingGPT처럼 LLM을 일종의 컨트롤 타워로 사용해서 다양한 모델들을 활용하는 방식을 제안했다는 점이 굉장히 트렌디하고 시대의 흐름을 잘 파악한 연구라고 생각합니다.

여러 개의 태스크를 잘 수행한다는 점, 즉 일반화 성능이 굉장히 뛰어나다는 LLM의 특징을 잘 활용한 방식이 앞으로도 활발히 연구될 것으로 예상됩니다.

단순히 역전파를 통해 학습이 이뤄지는 현재 인공지능 모델의 학습 방식으로는 AGI 실현이 절대 불가능하다는 입장도 많지만, HuggingGPT에 이름을 Jarvis라고 붙여줄만큼 사람들의 기대치도 충분히 높다는 것을 알 수 있습니다.

그런 측면에서 단순히 모델 카드 뿐만 아니라 데이터 카드를 모델 선정 및 아키텍쳐 구성에 활용했다는 점이 가장 칭찬할만한 요소라고 생각이 듭니다.

👎🏻

이전에 다른 인공지능 모델들의 특화된 능력을 활용하는 데 LLM을 사용할 수 있다는 대표적인 논문인 HuggingGPT나 Visual ChatGPT와 뭐가 다른지 이해가 되지 않았습니다.

Visual ChatGPT야 이미지 특화 모델에 한정된 computer vision domain의 모델이라고 하더라도.. HuggingGPT는 HuggingFace에 등록된 여러 모델들을 카드 정보를 이용하여 사용한다는 컨셉이었는데 제가 파악한 차이점은 없었습니다.

물론 딥러닝이 아닌 머신러닝 모델들을 활용한다는 점만 놓고 본다면 적은 데이터에 대해 더 좋은 성능을 보이는 분야에서는 의미가 있을 것 같습니다만, 지금의 연구 흐름을 생각해본다면 굳이 이것들을 ML로 처리할 수 있도록 만든 이유가 뭘까 싶었습니다.

또한 하이퍼 파라미터 튜닝에 대해서 의문이 많이 남습니다.

이전 연구 성과나 결과들을 기반으로 학습 로그를 생성해준다는데… 실제 학습이 이뤄지지 않고 결과만 가지고 예측한 것을 로그로 생성해도 되는 건가 싶습니다.

물론 실제 성능이 좋다면 할 말이 또 없게 되겠지만 결국 또 인공지능 모델의 발전을 블랙박스 안으로 가두는 듯한 느낌이 들었습니다.

출처 : https://arxiv.org/abs/2305.02499

AutoML-GPT: Automatic Machine Learning with GPT

AI tasks encompass a wide range of domains and fields. While numerous AI models have been designed for specific tasks and applications, they often require considerable human efforts in finding the right model architecture, optimization algorithm, and hyper

arxiv.org

'Paper Review' 카테고리의 다른 글

최근에 나온 논문을 읽어보고 간단히 정리했습니다.

혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️

GPT를 다양한 AI 모델들을 연결해주고 최적화된 하이퍼 파라미터를 제공해주는 수단으로 이용하는 방식을 제안한 논문

- 배경

LLM의 뛰어난 능력이 세간의 주목을 받게 되면서 여러 인공지능 모델을 통합하고자 하는 시도도 활발히 이뤄지고 있습니다.

그러나 말 그대로 거대한 사이즈의 모델들을 다루기 위해서는 굉장히 많은 자원이 필요하고, 각 태스크에 적합한 모델들을 어떻게 선정할 것인지가 명료하게 정리되기는 쉽지 않죠.

따라서 LLM을 통해 각 모델, 그리고 모델이 학습한 데이터에 대한 설명을 바탕으로 태스크에 적합한 모델을 선정하여 결과를 산출하는 방식을 적용해 볼 수 있습니다.

LLM은 데이터 처리, 아키텍쳐 디자인, 태스크에 적합한 실험 수행 등을 해줍니다.

- 컨셉

AutoML-GPT는 1) 모델/데이터 카드를 해석해 고정된 형태의 프롬프트 문단을 생성하고 2) 유저의 요청에 적합한 학습 파이프라인을 구축하여 3) 학습 로그를 생성한 뒤 4) 하이퍼 파라미터 튜닝을 진행합니다.

- 데이터 카드 : data name, input data type, label space, evaluation metric

- 모델 카드 : model name, model structure, model description, architecture hyperparameter

- 하이퍼 파라미터 튜닝 : 두 카드 정보를 바탕으로 학습 로그를 예측하여 생성하고 그 결과를 토대로 적절한 하이퍼 파라미터를 제안

- Unseen Datasets : 이전에 학습 경험이 없는 데이터셋에 대해서도 description으로부터의 상관관계를 통해 기학습된 결과를 전이할 수 있음

- 개인적 감상

👍🏻

최근 많은 사람들의 관심을 받았던 HuggingGPT처럼 LLM을 일종의 컨트롤 타워로 사용해서 다양한 모델들을 활용하는 방식을 제안했다는 점이 굉장히 트렌디하고 시대의 흐름을 잘 파악한 연구라고 생각합니다.

여러 개의 태스크를 잘 수행한다는 점, 즉 일반화 성능이 굉장히 뛰어나다는 LLM의 특징을 잘 활용한 방식이 앞으로도 활발히 연구될 것으로 예상됩니다.

단순히 역전파를 통해 학습이 이뤄지는 현재 인공지능 모델의 학습 방식으로는 AGI 실현이 절대 불가능하다는 입장도 많지만, HuggingGPT에 이름을 Jarvis라고 붙여줄만큼 사람들의 기대치도 충분히 높다는 것을 알 수 있습니다.

그런 측면에서 단순히 모델 카드 뿐만 아니라 데이터 카드를 모델 선정 및 아키텍쳐 구성에 활용했다는 점이 가장 칭찬할만한 요소라고 생각이 듭니다.

👎🏻

이전에 다른 인공지능 모델들의 특화된 능력을 활용하는 데 LLM을 사용할 수 있다는 대표적인 논문인 HuggingGPT나 Visual ChatGPT와 뭐가 다른지 이해가 되지 않았습니다.

Visual ChatGPT야 이미지 특화 모델에 한정된 computer vision domain의 모델이라고 하더라도.. HuggingGPT는 HuggingFace에 등록된 여러 모델들을 카드 정보를 이용하여 사용한다는 컨셉이었는데 제가 파악한 차이점은 없었습니다.

물론 딥러닝이 아닌 머신러닝 모델들을 활용한다는 점만 놓고 본다면 적은 데이터에 대해 더 좋은 성능을 보이는 분야에서는 의미가 있을 것 같습니다만, 지금의 연구 흐름을 생각해본다면 굳이 이것들을 ML로 처리할 수 있도록 만든 이유가 뭘까 싶었습니다.

또한 하이퍼 파라미터 튜닝에 대해서 의문이 많이 남습니다.

이전 연구 성과나 결과들을 기반으로 학습 로그를 생성해준다는데… 실제 학습이 이뤄지지 않고 결과만 가지고 예측한 것을 로그로 생성해도 되는 건가 싶습니다.

물론 실제 성능이 좋다면 할 말이 또 없게 되겠지만 결국 또 인공지능 모델의 발전을 블랙박스 안으로 가두는 듯한 느낌이 들었습니다.

출처 : https://arxiv.org/abs/2305.02499

AutoML-GPT: Automatic Machine Learning with GPT

AI tasks encompass a wide range of domains and fields. While numerous AI models have been designed for specific tasks and applications, they often require considerable human efforts in finding the right model architecture, optimization algorithm, and hyper

arxiv.org