![]()

관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ [KAIST, LG AI Research] - input과 label이 주어지면 instruction을 예측하도록 하는 meta-training method, Flipped Learning - unlikelihood loss를 추가 (weighted sum with likelihood loss) - unseen labels을 지닌 task에서 큰 성능 향상을 보임 배경 기존 LM (Language Models)은 input과 instruction이 주어지면 label을 예측하는 방식으로 학습을 진행 학습 때와 다른 label을 지닌 데이터에 대한 추론 성능이 떨어짐. 즉 일반화 성능이 좋..

![]()

[Naver, KAIST, SNU] - human annotation이나 proprietary LLM에 의존하지 않고 합성 데이터를 이용하는 alignment learning framework - vanilla LLM으로부터의 output을 대조시키는 방식으로 reward modeling을 진행 - RM을 이용하여 high-quality demonstration에 대해 supervised policy를 학습 - model을 강화학습을 통해 optimize 배경 Alignment learning은 large language model의 성능 향상에 큰 영향을 주었지만 관련 데이터 확보나 학습 관점에서 비용이 너무 많이 든다는 문제점이 존재 본 논문에서는 합성 데이터를 생성함으로써 위 방식의 단점을 극복하고..

![]()

관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ [KAIST, LG AI Research, Knokuk University, Seoul National University, University of Illinois Chicago] - LM이 지난 privacy risk를 줄여주기 위한 대안으로 knowledge unlearning을 제안 - target sequence에 대해 gradient ascent를 적용하는 것만으로도 모델의 성능 하락 없이 forgetting을 쉽게 달성할 수 있음 - sequential unlearning이 모든 데이터를 한꺼번에 처리하는 것보다 더 바람직한 결과로 이어짐 배경 사전 학습된 언어 모델이 이름,..

![]()

관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. (Language & Knowledge Lab의 Retreival 관련) 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ [KAIST, LG AI Research, Korea University] - LM이 이전의 지식을 그대로 보유하고 있는지, 그리고 최신의 지식을 습득했는지 확인할 수 있는 벤치마크 - TWiki-Diffsets, TWiki-Probes 두 개의 셋으로 구성 - diff data에 대해 LM을 continual learning 하는 것이 perplexity 관점에서 준수하다는 결과 배경 LM의 능력을 평가하는 데이터셋은 대부분 static train / test 데이터셋의 misalignment는 closed-boo..

![]()

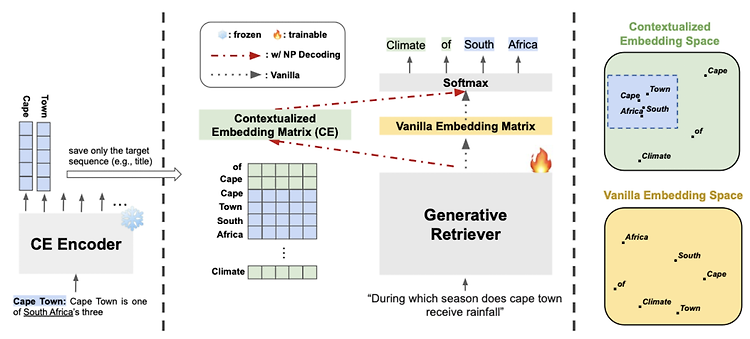

관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. (Language & Knowledge Lab의 Retreival 관련) 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ [KAIST AI, Kakao] - 현존하는 generative retrieval model에 모두 적용 가능한 Nonparametric Decoding (Np Decoding)을 제안 - Np Decoding은 nonparametric contextualized vocab embedding (external memory)를 사용 배경 Text Retrieval에서 bi-encoder를 사용하는 방식은 embedding space bottleneck과 large storage space 문제가 존재 최근 인기를 끌고..

![]()

관심있는 NLP 논문을 읽어보고 간단히 정리했습니다. (Language & Knowledge Lab의 Retreival 관련) 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ [RAG] Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks (2021.04) [Facebook AI Research] - parametric memory는 사전학습된 seq2seq, non-parametric momory는 위키피디아의 dense vector index - 하나의 retrieved passage로 sequence 전체를 생성하는 방식 vs 각 토큰별로 다른 retrieved passage를 참고하는 방식� 배경 사전학습된 Neural..