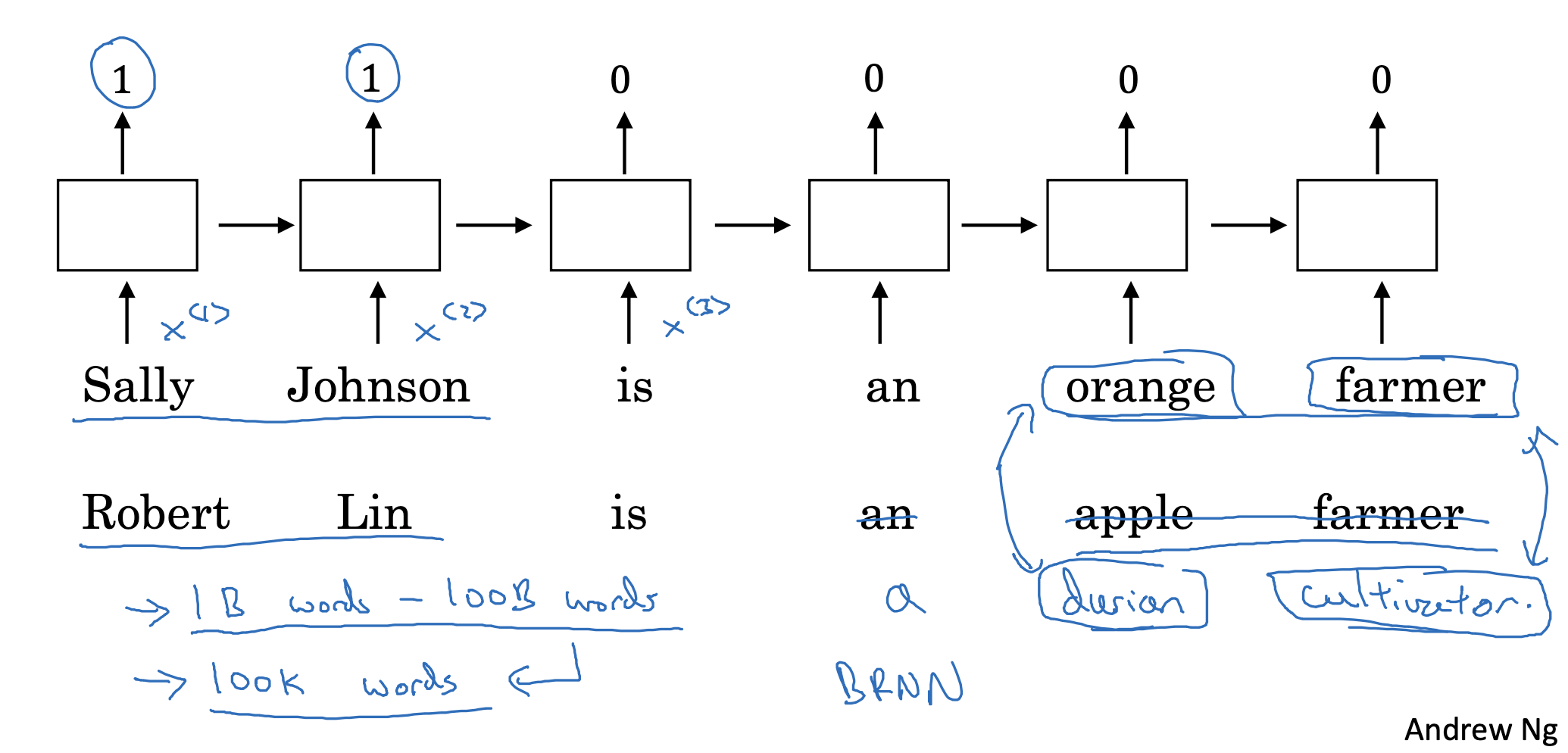

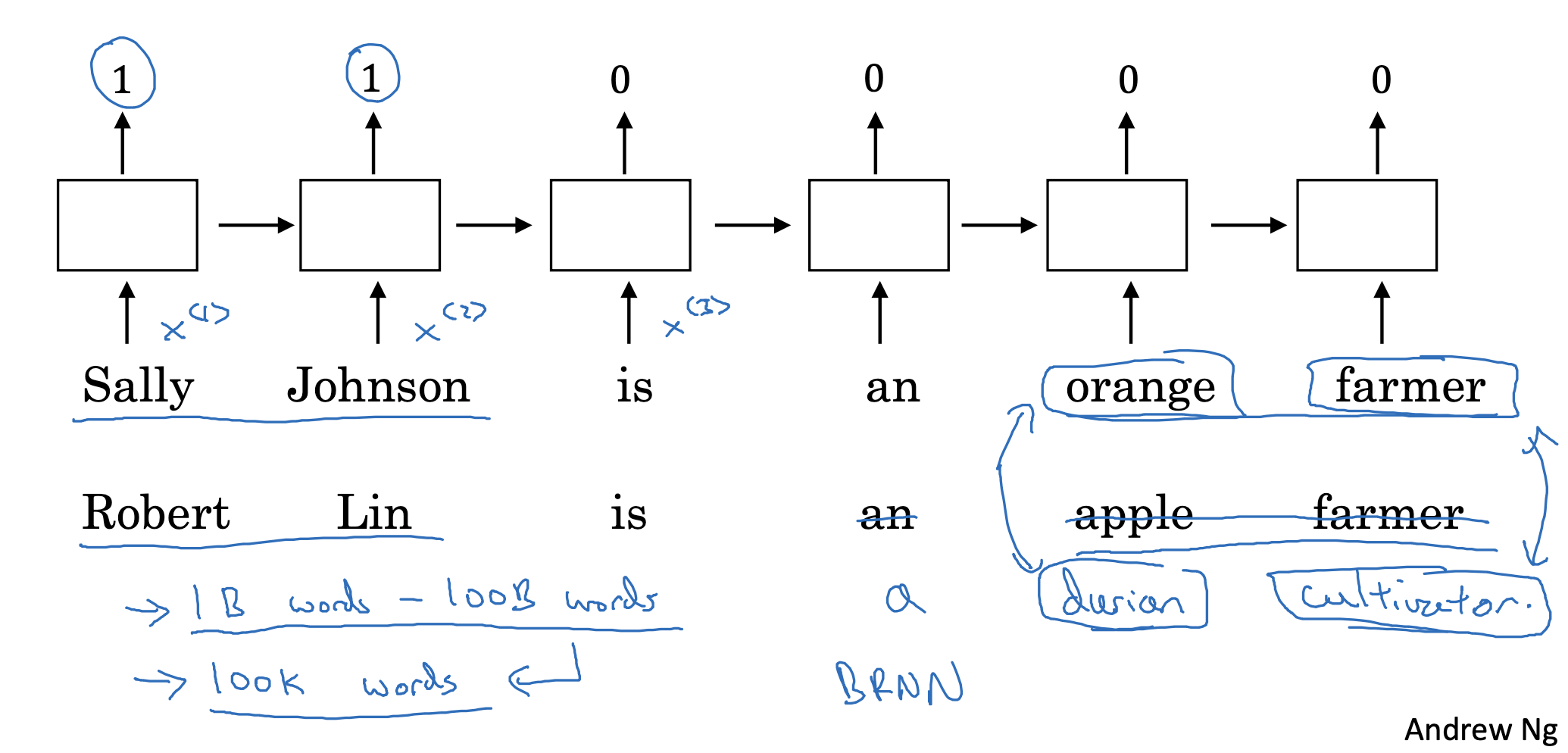

Named entity recognition example

One-hot encoding 대신 word embedding을 활용할 수 있는 예시인 NER 태스크입니다.

이때는 학습된 word embedding을 이용하여 심지어 처음 보거나 익숙하지 않은 단어, 혹은 문구까지도 처리할 수 있습니다.

- 예를 들어 우리가 학습시킨 단어 중에 durian, cultivator라는 단어가 없었다고 하더라도, 이들이 위치하는 자리의 특성을 파악하여 durian은 과일, cultivator는 직업 중 하나로 인지할 수 있다는 뜻입니다.

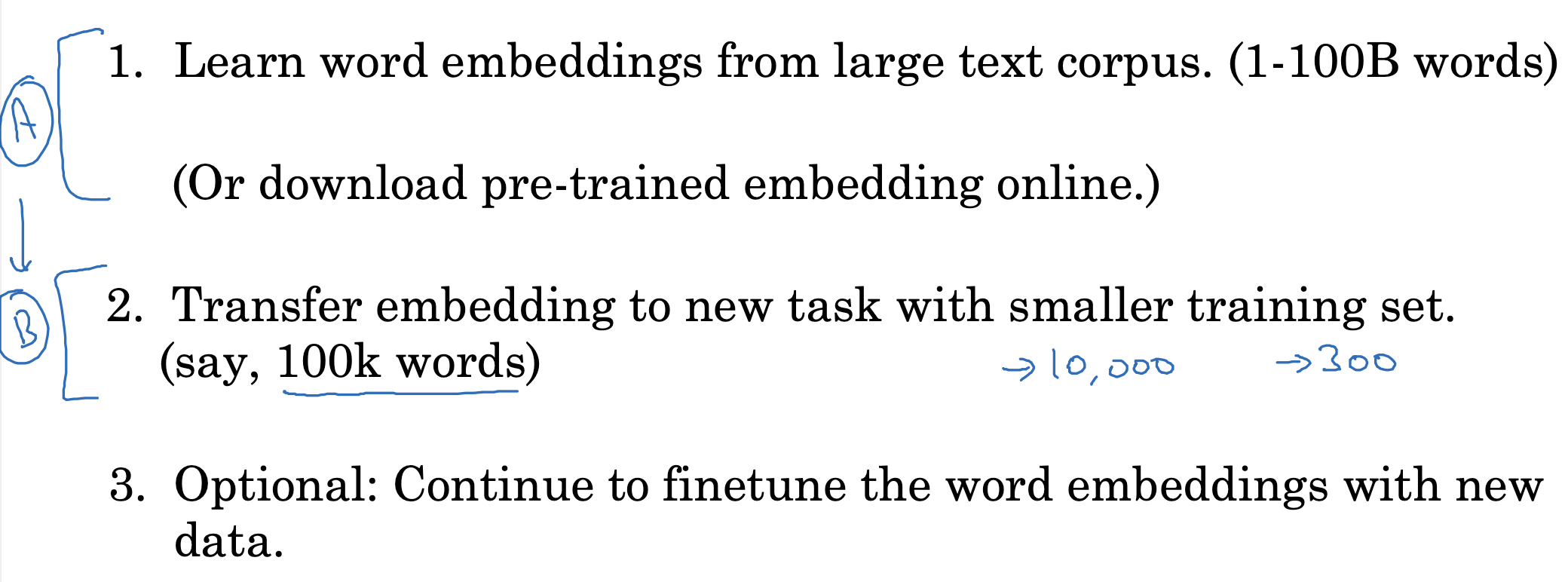

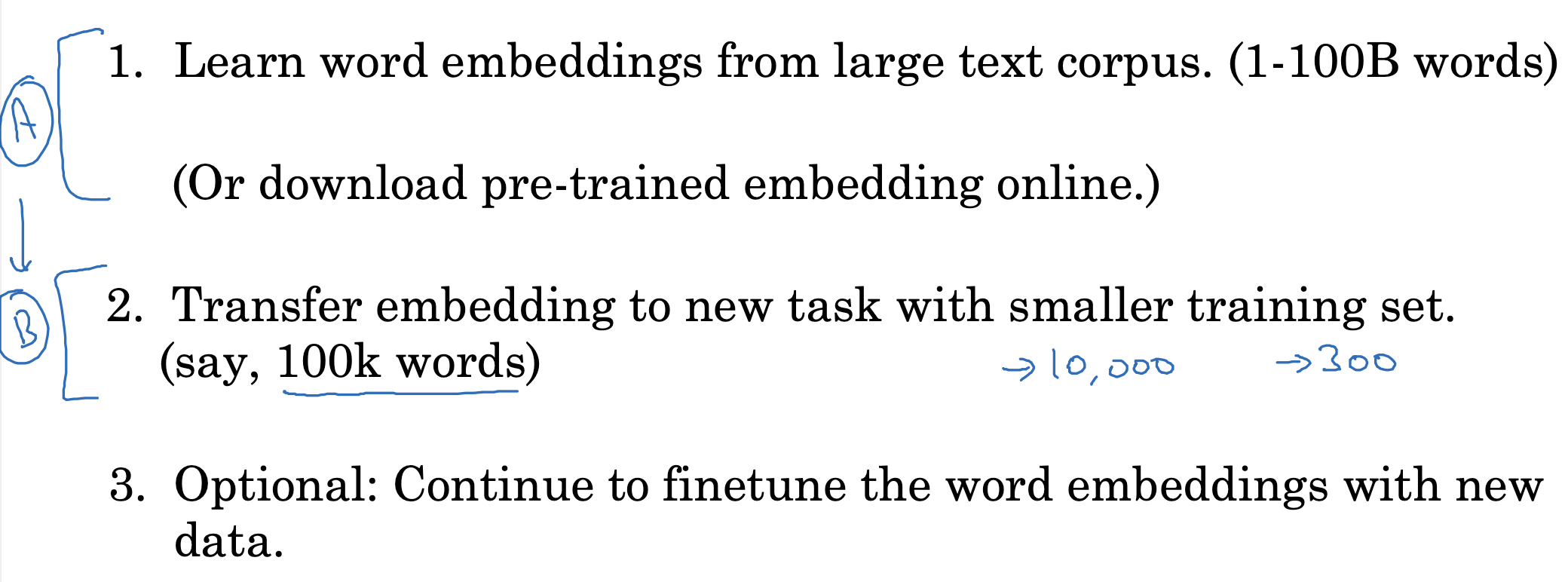

Transfer learning and word embeddings

여기에는 Transfer learning(전이 학습)의 개념이 적용되는데 그 원리 자체는 엄청 간단합니다.

- 우선 대량의 corpus(말뭉치)로 학습을 합니다. 물론 사전에 학습된 embedding 자체를 다운로드 받을 수도 있습니다.

- 그리고 이를 작은 training set에 transfer합니다.

- 추가적으로 새로운 데이터에 대해서 학습하게 만들 수도 있습니다.

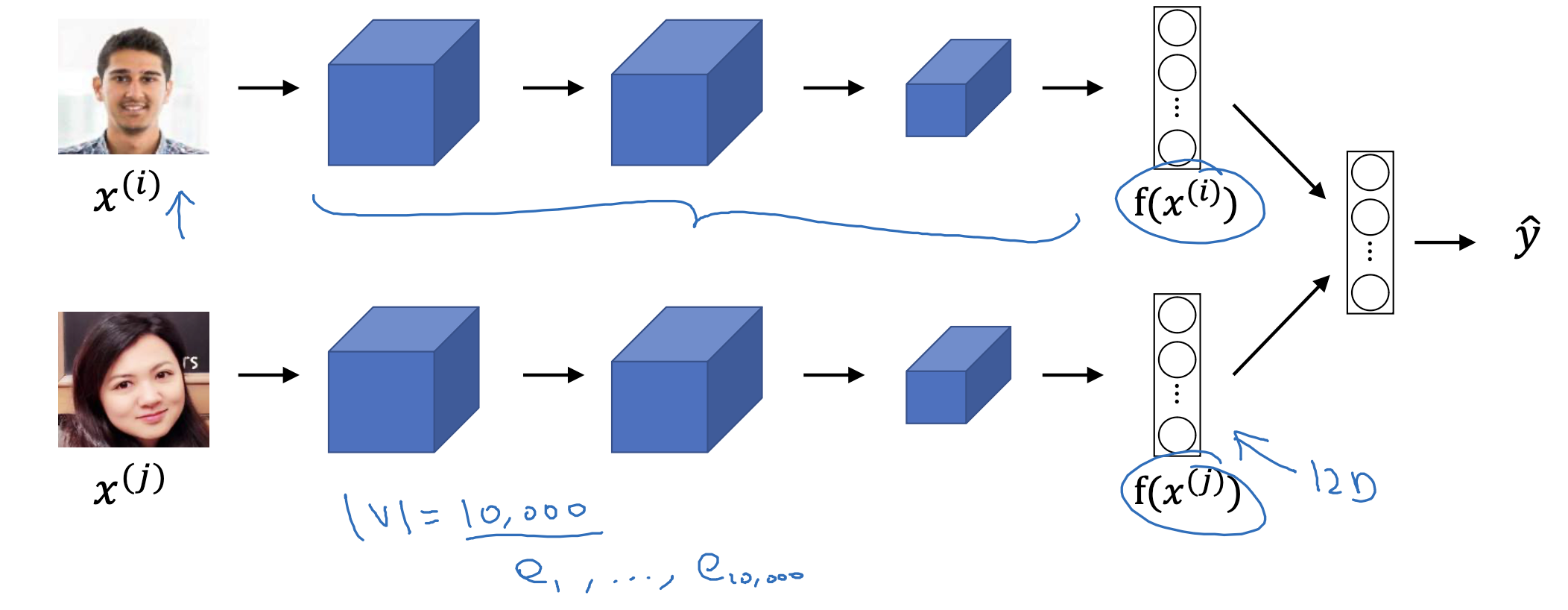

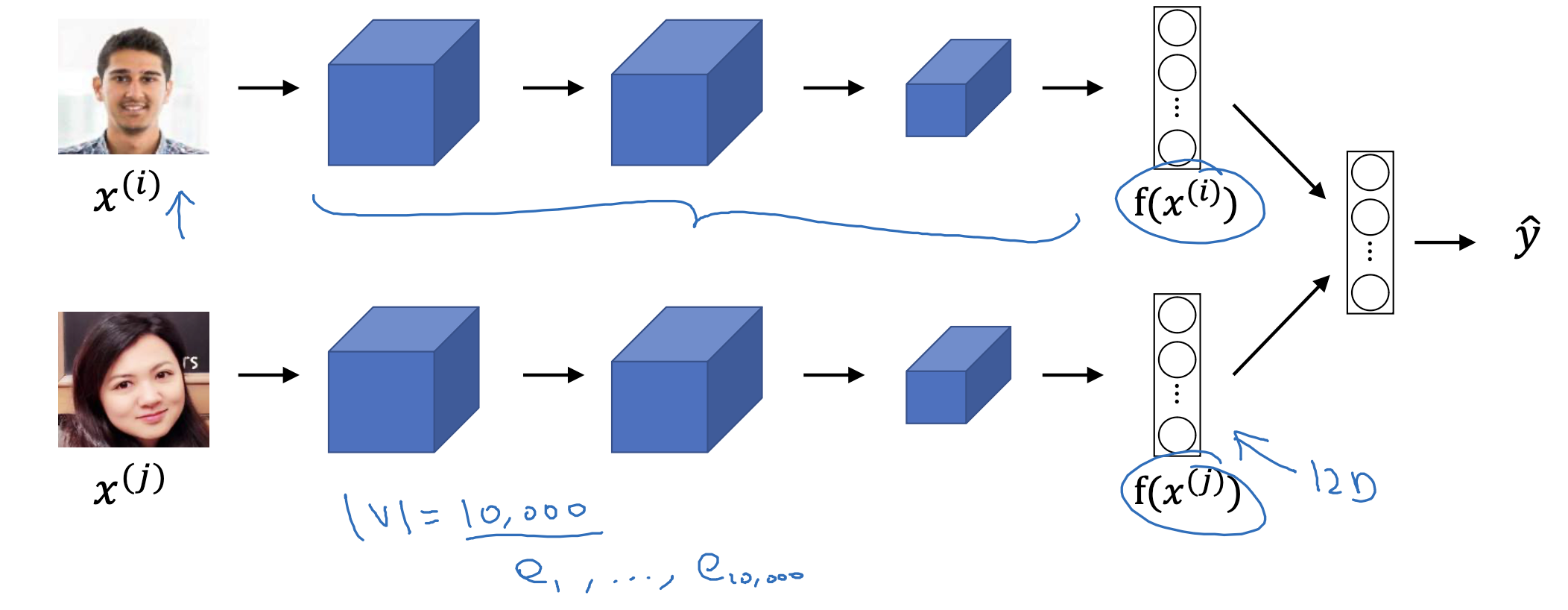

Relation to face encoding

이러한 방식은 기존 얼굴 인식(feac recognition)에서 사용되는 embedding에도 동일하게 적용 가능한 개념이므로 이를 이후에 비교하여 강의할 계획이라고 하십니다.

출처: Coursera, Sequence Models, DeepLearning.AI

'Sequence Models > 2주차' 카테고리의 다른 글

| Learning Word Embeddings(3) : Negative Sampling (0) | 2023.04.24 |

|---|---|

| Learning Word Embeddings(2) : Word2Vec (0) | 2023.04.24 |

| Learning Word Embeddings(1) : Learning Word Embeddings (0) | 2023.04.22 |

| Introduction to Word Embeddings(3),(4) : Properties of Word Embeddings, Embedding Matrix (0) | 2023.04.21 |

| Introduction to Word Embeddings(1) : Word Representation (0) | 2023.04.21 |

Named entity recognition example

One-hot encoding 대신 word embedding을 활용할 수 있는 예시인 NER 태스크입니다.

이때는 학습된 word embedding을 이용하여 심지어 처음 보거나 익숙하지 않은 단어, 혹은 문구까지도 처리할 수 있습니다.

- 예를 들어 우리가 학습시킨 단어 중에 durian, cultivator라는 단어가 없었다고 하더라도, 이들이 위치하는 자리의 특성을 파악하여 durian은 과일, cultivator는 직업 중 하나로 인지할 수 있다는 뜻입니다.

Transfer learning and word embeddings

여기에는 Transfer learning(전이 학습)의 개념이 적용되는데 그 원리 자체는 엄청 간단합니다.

- 우선 대량의 corpus(말뭉치)로 학습을 합니다. 물론 사전에 학습된 embedding 자체를 다운로드 받을 수도 있습니다.

- 그리고 이를 작은 training set에 transfer합니다.

- 추가적으로 새로운 데이터에 대해서 학습하게 만들 수도 있습니다.

Relation to face encoding

이러한 방식은 기존 얼굴 인식(feac recognition)에서 사용되는 embedding에도 동일하게 적용 가능한 개념이므로 이를 이후에 비교하여 강의할 계획이라고 하십니다.

출처: Coursera, Sequence Models, DeepLearning.AI

'Sequence Models > 2주차' 카테고리의 다른 글

| Learning Word Embeddings(3) : Negative Sampling (0) | 2023.04.24 |

|---|---|

| Learning Word Embeddings(2) : Word2Vec (0) | 2023.04.24 |

| Learning Word Embeddings(1) : Learning Word Embeddings (0) | 2023.04.22 |

| Introduction to Word Embeddings(3),(4) : Properties of Word Embeddings, Embedding Matrix (0) | 2023.04.21 |

| Introduction to Word Embeddings(1) : Word Representation (0) | 2023.04.21 |