![]()

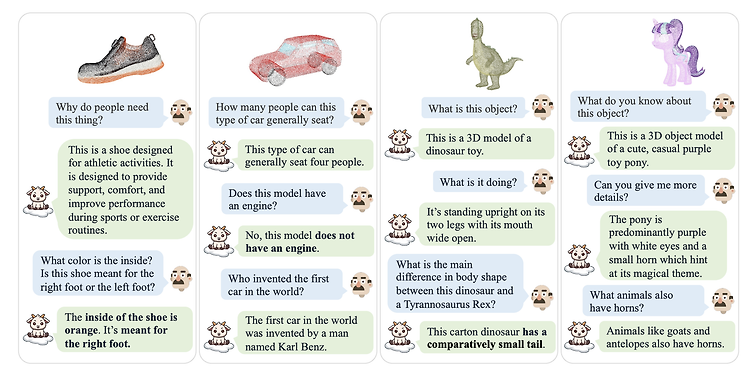

이 글은 최근(2023.08)에 나온 논문의 요약본을 ChatGPT로 번역한 것입니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success 개요 이 논문은 대형 언어 모델(Large Language Models, LLMs)이 3D 포인트 클라우드를 이해할 수 있도록 확장하는 새로운 연구 방향을 제시합니다. 이로써, 2D 시각 데이터 이상의 새로운 연구 영역이 열립니다. 중심 문제 기존의 대형 언어 모델은 자연어 처리에는 능숙하지만, 3D 구조를 이해하는 능력은 부족합니다. 2D 이미지를 위한 LVLMs는 활발히 연구되고 있지만, 3D로 확장되지 않습니다. 이러한 한계는 3D 환경에서의 객체 인식 및 상호 작용과 같은 작업에 그 응용을 제한합니다. 또..

![]()

예전(2021.12)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success [Facebook AI Research (FAIR)] 여러 modality를 '한 번에' 처리할 수 있는 foundation 모델 FLAVA. vision, language, cross/multi-modal vision-langue task 전부 처리. 배경 그렇게 오래 전도 아니지만 이때만 하더라도 multi-modal 모델들의 성능은 지금과 사뭇 달랐던 것 같습니다. 본 논문에서 지적하고 있는 기존 모델들의 한계는 결국 모델의 능력이 '특정 modality에 국한'되어 있다는 것입니다. 여러 modality를 동시에 잘 이해하고 ..

![]()

최근(2023.08)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success [Meta AI] LLAMA 2를 기반으로 학습된 CODE LLAMA 모델들을 공개. CODE LLAMA, CODE LLAMA - PYTHON, CODE LLAMA -INSTRUCT 세 버전. 각각 7B, 13B, 34B 파라미터 사이즈로 공개. 배경 거대언어모델이 사용한 학습 데이터셋에는 영어 다음으로 많은 비중을 차지하고 있는 것이 python이라는 말이 있습니다. 그만큼 프로그래밍 언어를 학습한 것이 모델의 일반적인 성능 향상에 도움이 된다는 것이 잘 알려져 있습니다. 이에 따라 프로그래밍 언어로 이뤄진 데이터셋을 학습하여 일반..

![]()

최근(2023.08)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success [NVIDIA, USA] retrieval-augmented masked language modeling과 prefix language modeling을 결합한 모델, RAVEN. 추가적인 학습이나 모델의 변형 없이 few-shot performance를 향상시킬 수 있는 Fusion-in-Context-Learning(FiCL)를 제안. 배경 LLM의 general한 능력, 즉 다양한 태스크를 잘 수행할 수 있는 능력은 충분히 입증되었지만, 각 태스크에 맞게끔 tuning하는 것은 너무 많은 비용을 필요로 한다는 문제점이 있습니다...

![]()

최근(2023.08)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success [Meta AI] 최소한의 annotated instruction data를 이용하여 모델을 학습. 이를 바탕으로 self-augmentation & self-curation을 수행하는 기법, instruction backtranslation. 배경 LLM을 instruction tuning함으로써 모델의 성능을 크게 향상시킬 수 있음이 잘 알려져 있습니다. 그러나 이를 위해 human-annotated data를 갖추는 것은 많은 비용을 필요로 하기 때문에, 성능을 크게 높일 수 있는 방식이 알려져 있음에도 불구하고 데이터셋 확보에..

![]()

최근(2023.06)에 나온 논문을 읽어보고 간단히 정리했습니다. 혹시 부족하거나 잘못된 내용이 있다면 댓글 부탁드립니다 🙇♂️ usechatgpt init success BLIP-2, generic & efficient 사전 학습 Vision & Language Model. frozen image encoder & frozen LLM으로 Querying Transformer를 2-step으로 학습. 배경 이전의 vision-language model을 특정 태스크에 맞게끔 end-to-end 학습하는 방식은 지나치게 많은 자원을 필요로 한다는 문제점이 있었습니다. 본 논문은 자원상의 한계를 극복하면서도 준수한 vision-language model을 만들기 위한 사전 학습 전략을 제시하고 있습니다. ..